Lors d’un événement virtuel ce matin, Meta a levé le voile sur ses efforts de développement d’une infrastructure interne pour les charges de travail d’IA, y compris l’IA générative comme celle qui sous-tend ses outils de conception et de création d’annonces récemment lancés.

Il s’agissait d’une tentative de démonstration de force de la part de Meta, qui a toujours été lente à adopter des systèmes matériels adaptés à l’IA, ce qui l’a empêchée de suivre le rythme de ses rivaux tels que Google et Microsoft.

« Construire nos propres capacités (matérielles) nous permet de contrôler chaque couche de la pile, de la conception du centre de données aux cadres de formation », a déclaré Alexis Bjorlin, vice-président de l’infrastructure chez Meta, à TechCrunch. « Ce niveau d’intégration verticale est nécessaire pour repousser les limites de la recherche en IA à grande échelle. »

Au cours de la dernière décennie, Meta a dépensé des milliards de dollars pour recruter les meilleurs scientifiques des données et construire de nouveaux types d’IA, y compris l’IA qui alimente maintenant les moteurs de découverte, les filtres de modération et les recommandeurs d’annonces que l’on trouve dans ses applications et services. Mais l’entreprise a eu du mal à transformer en produits nombre de ses innovations les plus ambitieuses en matière de recherche sur l’IA, en particulier dans le domaine de l’IA générative.

Jusqu’en 2022, Meta a largement exécuté ses charges de travail d’IA en utilisant une combinaison de CPU – qui ont tendance à être moins efficaces pour ce genre de tâches que les GPU – et une puce personnalisée conçue pour accélérer les algorithmes d’IA. Meta a mis fin au déploiement à grande échelle de la puce personnalisée, qui était prévu pour 2022, et a préféré passer commande de milliards de dollars de GPU Nvidia, ce qui a nécessité une refonte majeure de plusieurs de ses centres de données.

Afin de redresser la barre, Meta a prévu de commencer à développer une puce interne plus ambitieuse, prévue pour 2025, capable d’entraîner des modèles d’IA et de les faire fonctionner. C’était le sujet principal de la présentation d’aujourd’hui.

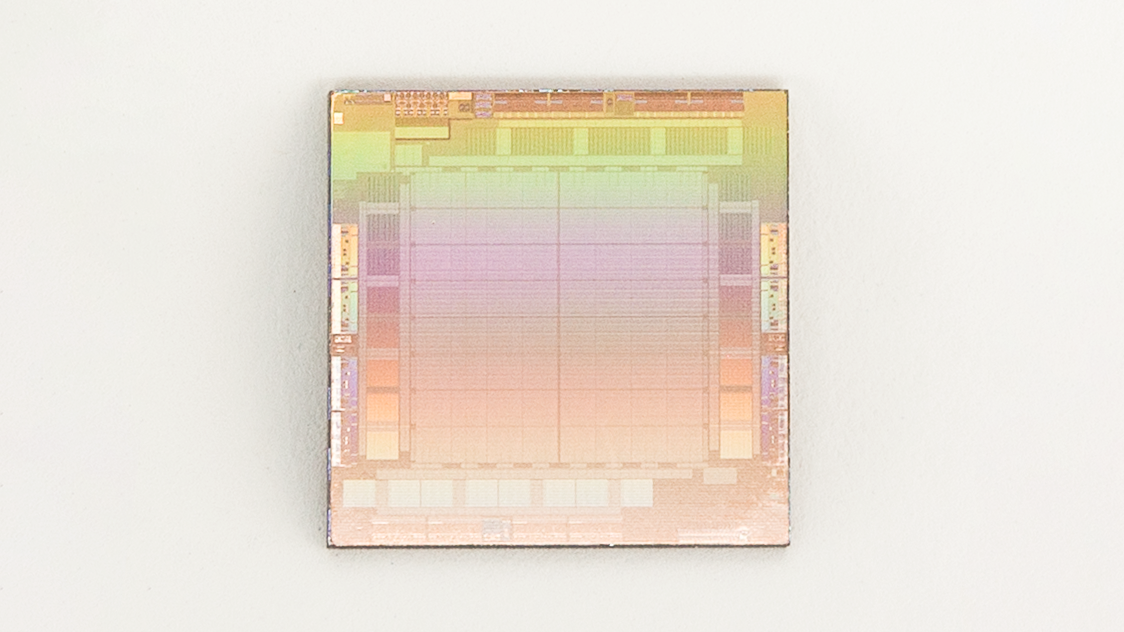

Meta appelle cette nouvelle puce Meta Training and Inference Accelerator, ou MTIA en abrégé, et la décrit comme faisant partie d’une « famille » de puces destinées à accélérer les charges de travail d’entraînement et d’inférence de l’IA. (Le MTIA est un ASIC, un type de puce qui combine différents circuits sur une même carte, ce qui lui permet d’être programmé pour exécuter une ou plusieurs tâches en parallèle.

Une puce d’IA conçue sur mesure par Meta pour les charges de travail d’IA.

« Pour obtenir de meilleurs niveaux d’efficacité et de performance dans nos charges de travail importantes, nous avions besoin d’une solution sur mesure conçue conjointement avec le modèle, la pile logicielle et le matériel du système », poursuit M. Bjorlin. « Cela permet à nos utilisateurs de bénéficier d’une meilleure expérience dans toute une série de services.. »

Les puces d’IA personnalisées sont de plus en plus prisées par les grands acteurs de la technologie. Google a créé un processeur, le TPU (abréviation de « tensor processing unit »), pour entraîner de grands systèmes d’IA générative comme PaLM-2 et Imagen. Amazon propose des puces propriétaires aux clients d’AWS pour l’entraînement (Trainium) et l’inférence (Inferentia). Enfin, Microsoft travaillerait avec AMD pour développer une puce d’IA interne appelée Athena.

Meta affirme avoir créé la première génération de MTIA – MTIA v1 – en 2020, construite sur un processus de 7 nanomètres. Elle peut s’étendre au-delà de ses 128 Mo de mémoire interne jusqu’à 128 Go, et dans un test de référence conçu par Meta – qui, bien sûr, doit être pris avec un grain de sel – Meta affirme que la MTIA a traité des modèles d’IA « peu complexes » et « moyennement complexes » plus efficacement qu’un GPU.

Selon Meta, il reste du travail à faire dans les domaines de la mémoire et du réseau de la puce, qui présentent des goulets d’étranglement à mesure que la taille des modèles d’IA augmente, ce qui nécessite de répartir les charges de travail sur plusieurs puces. (Ce n’est pas une coïncidence si Meta a récemment acquis une équipe basée à Oslo qui développe la technologie de mise en réseau de l’IA chez Graphcore, une licorne britannique du secteur des puces). Pour l’instant, la MTIA se concentre strictement sur l’inférence – et non sur l’entraînement – pour les « charges de travail de recommandation » dans la famille d’applications de Meta.

Mais Meta a souligné que la MTIA, qu’elle continue d’affiner, augmente « considérablement » l’efficacité de l’entreprise en termes de performances par watt lors de l’exécution de charges de travail de recommandation – ce qui permet à Meta d’exécuter des charges de travail d’IA « plus améliorées » et « à la pointe de la technologie » (ostensiblement).

Un supercalculateur pour l’IA

Peut-être qu’un jour, Meta reléguera la majeure partie de ses charges de travail d’IA à des banques de MTIA. Mais pour l’instant, le réseau social s’appuie sur les GPU de son supercalculateur de recherche, le Research SuperCluster (RSC).

Dévoilé pour la première fois en janvier 2022, le RSC – assemblé en partenariat avec Penguin Computing, Nvidia et Pure Storage – a achevé sa deuxième phase de construction. Meta indique qu’il contient désormais un total de 2 000 systèmes Nvidia DGX A100 équipés de 16 000 GPU Nvidia A100.

Pourquoi construire un supercalculateur en interne ? Tout d’abord, il y a la pression des pairs. Il y a plusieurs années, Microsoft a fait grand cas de son supercalculateur d’IA construit en partenariat avec OpenAI, et a récemment annoncé qu’il s’associerait à Nvidia pour construire un nouveau supercalculateur d’IA dans le nuage Azure. Par ailleurs, Google a vanté les mérites de son propre supercalculateur axé sur l’IA, qui compte 26 000 GPU Nvidia H100, ce qui le place devant celui de Meta.

Le supercalculateur de Meta pour la recherche en IA.

Mais au-delà du fait de suivre les Jones, Meta affirme que le RSC offre l’avantage de permettre à ses chercheurs d’entraîner des modèles en utilisant des exemples du monde réel provenant des systèmes de production de Meta. Contrairement à la précédente infrastructure d’IA de l’entreprise, qui n’utilisait que des ensembles de données open source et accessibles au public, le RSC permet à ses chercheurs d’entraîner des modèles en utilisant des exemples réels issus des systèmes de production de Meta.

« Le supercalculateur RSC AI est utilisé pour repousser les limites de la recherche en IA dans plusieurs domaines, y compris l’IA générative », a déclaré un porte-parole de Meta. « Il s’agit en fait de la productivité de la recherche en IA. Nous voulions fournir aux chercheurs en IA une infrastructure de pointe pour qu’ils puissent développer des modèles et leur donner les moyens de disposer d’une plateforme de formation pour faire progresser l’IA. »

À son apogée, le RSC peut atteindre une puissance de calcul de près de 5 exaflops, ce qui, selon l’entreprise, en fait l’un des systèmes les plus rapides au monde. (Pour ne pas impressionner, il convient de noter que certains experts considèrent la mesure des performances exaflops avec une pincée de sel et que le RSC est largement dépassé par de nombreux supercalculateurs parmi les plus rapides au monde).

Meta affirme avoir utilisé le RSC pour entraîner LLaMA, un acronyme torturé pour « Large Language Model Meta AI » – un grand modèle de langage que l’entreprise a partagé en tant que « gated release » avec des chercheurs plus tôt dans l’année (et qui a ensuite fait l’objet de fuites dans diverses communautés Internet). Le plus grand modèle LLaMA a été entraîné sur 2 048 GPU A100, selon Meta, ce qui a pris 21 jours.

« Construire nos propres capacités de supercalcul nous permet de contrôler chaque couche de la pile, de la conception du centre de données aux cadres de formation », a ajouté le porte-parole. « RSC aidera les chercheurs en IA de Meta à construire de nouveaux et meilleurs modèles d’IA capables d’apprendre à partir de trillions d’exemples, de travailler dans des centaines de langues différentes, d’analyser de manière transparente du texte, des images et des vidéos, de développer de nouveaux outils de réalité augmentée, et bien plus encore. »

Transcodeur vidéo

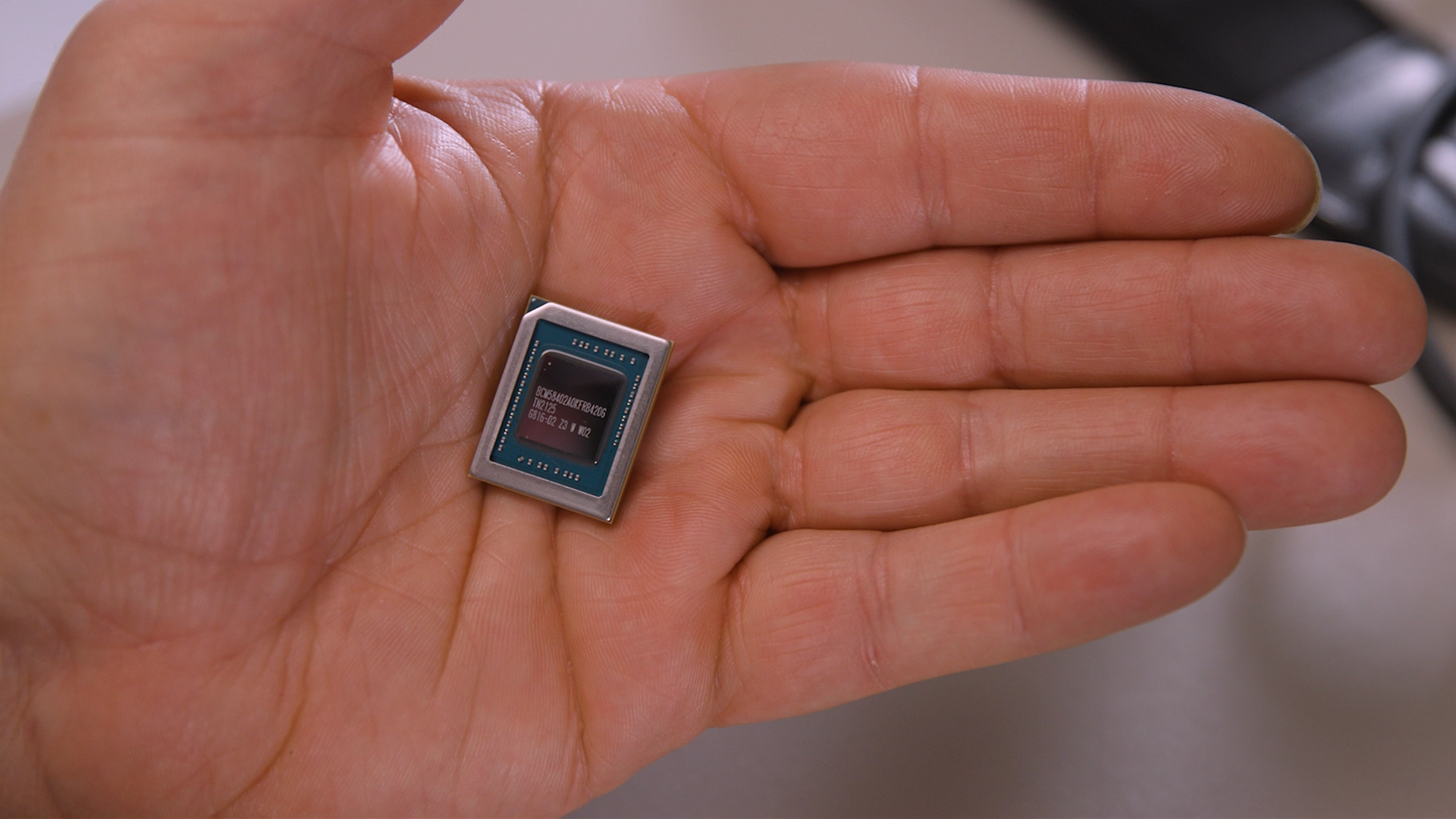

En plus de MTIA, Meta développe une autre puce pour gérer des types particuliers de charges de travail informatiques, a révélé la société lors de l’événement d’aujourd’hui. Baptisé Meta Scalable Video Processor (MSVP), Meta affirme qu’il s’agit de sa première solution ASIC développée en interne et conçue pour répondre aux besoins de traitement de la vidéo à la demande et de la diffusion en direct.

Meta a commencé à imaginer des puces vidéo personnalisées côté serveur il y a des années, les lecteurs s’en souviendront peut-être, annonçant un ASIC pour le transcodage vidéo et le travail d’inferencing en 2019. Ceci est le fruit de certains de ces efforts, ainsi qu’un nouvel effort pour obtenir un avantage concurrentiel dans le domaine de la vidéo en direct en particulier.

« Rien que sur Facebook, les gens passent 50 % de leur temps sur l’application à regarder des vidéos », ont écrit les responsables techniques de Meta, Harikrishna Reddy et Yunqing Chen, dans un billet de blog coécrit publié ce matin. « Pour servir la grande variété d’appareils dans le monde entier (appareils mobiles, ordinateurs portables, téléviseurs, etc.), les vidéos téléchargées sur Facebook ou Instagram, par exemple, sont transcodées en plusieurs flux binaires, avec différents formats d’encodage, résolutions et qualités… MSVP est programmable et évolutif, et peut être configuré pour prendre en charge efficacement à la fois le transcodage de haute qualité nécessaire pour la VOD, ainsi que la faible latence et les temps de traitement plus rapides que nécessite la diffusion en direct. »

Puce personnalisée de Meta conçue pour accélérer les charges de travail vidéo, telles que le streaming et le transcodage.

Meta indique que son plan consiste à transférer la majorité de ses charges de travail de traitement vidéo « stables et matures » vers le MSVP et à n’utiliser l’encodage vidéo logiciel que pour les charges de travail nécessitant une personnalisation spécifique et une qualité « nettement » supérieure. Le travail se poursuit sur l’amélioration de la qualité vidéo avec le MSVP en utilisant des méthodes de prétraitement telles que le débruitage intelligent et l’amélioration de l’image, selon Meta, ainsi que des méthodes de post-traitement telles que la suppression des artefacts et la super-résolution.

« À l’avenir, MSVP nous permettra de prendre en charge encore plus de cas d’utilisation et de besoins les plus importants de Meta, y compris les vidéos de courte durée – permettant une diffusion efficace de l’IA générative, de l’AR/VR et d’autres contenus métavers », ont déclaré Reddy et Chen.

L’IA en point de mire

S’il y a un fil conducteur dans les annonces matérielles d’aujourd’hui, c’est que Meta tente désespérément d’accélérer le rythme en ce qui concerne l’IA, et plus particulièrement l’IA générative.

Tout cela avait déjà été annoncé. En février, le PDG Mark Zuckerberg – qui aurait fait de l’augmentation de la capacité de calcul de Meta pour l’IA une priorité absolue – a annoncé la création d’une nouvelle équipe d’IA générative de haut niveau pour, selon ses termes, » donner un coup de fouet » à la R & D de l’entreprise. Le directeur technique Andrew Bosworth a également déclaré récemment que l’IA générative était le domaine auquel lui et Zuckerberg consacraient le plus de temps. Le scientifique en chef Yann LeCun a déclaré que Meta prévoyait de déployer des outils d’IA générative pour créer des objets dans la réalité virtuelle,

« Nous explorons des expériences de chat dans WhatsApp et Messenger, des outils de création visuelle pour les posts dans Facebook et Instagram et les publicités, et avec le temps, des expériences vidéo et multimodales également », a déclaré Zuckerberg lors de la conférence téléphonique sur les résultats du premier trimestre de Meta en avril. « Je m’attends à ce que ces outils soient précieux pour tout le monde, des gens ordinaires aux créateurs en passant par les entreprises. Par exemple, je m’attends à ce que les agents d’intelligence artificielle pour la messagerie professionnelle et l’assistance à la clientèle suscitent beaucoup d’intérêt une fois que nous aurons mis la main sur cette expérience. Au fil du temps, cela s’étendra également à notre travail sur le métavers, où les gens pourront beaucoup plus facilement créer des avatars, des objets, des mondes et du code pour relier tous ces éléments entre eux. »

Meta subit en partie la pression croissante des investisseurs qui craignent que l’entreprise n’avance pas assez vite pour conquérir le marché (potentiellement important) de l’IA générative. Elle n’a pas encore de réponse aux chatbots tels que Bard, Bing Chat ou ChatGPT. Elle n’a pas non plus beaucoup progressé dans le domaine de la génération d’images, un autre segment clé qui connaît une croissance explosive.

Si les prévisions sont justes, le marché total des logiciels d’IA générative pourrait s’élever à 150 milliards de dollars. Goldman Sachs prévoit une augmentation du PIB de 7 %.

Même une petite partie de cette somme pourrait effacer les milliards que Meta a perdus en investissements dans les technologies du « métavers », comme les casques de réalité augmentée, les logiciels de réunion et les terrains de jeu VR tels que Horizon Worlds. Reality Labs, la division de Meta responsable des technologies de réalité augmentée, a déclaré une perte nette de 4 milliards de dollars au dernier trimestre, et la société a déclaré lors de son appel du premier trimestre qu’elle s’attendait à ce que « les pertes d’exploitation augmentent d’une année sur l’autre en 2023 ».