La startup d’IA Anthropic, soutenue par des centaines de millions de capital-risque (et peut-être bientôt des centaines de millions supplémentaires), a annoncé aujourd’hui la dernière version de sa technologie GenAI, Claude. L’entreprise affirme qu’elle rivalise avec GPT-4 d’OpenAI en termes de performances.

Claude 3, comme s’appelle la nouvelle GenAI d’Anthropic, est une famille de modèles – Claude 3 Haiku, Claude 3 Sonnet, et Claude 3 Opus, Opus étant le plus puissant. Tous présentent des « capacités accrues » en matière d’analyse et de prévision, affirme Anthropic, ainsi que des performances accrues sur des benchmarks spécifiques par rapport à des modèles tels que GPT-4 (mais pas GPT-4 Turbo) et Gemini 1.0 Ultra de Google (mais pas Gemini 1.5 Pro).

Notamment, Claude 3 est la première GenAI multimodale d’Anthropic, ce qui signifie qu’elle peut analyser du texte aussi bien que des images – comme certaines variantes de GPT-4 et de Gemini. Claude 3 peut traiter des photos, des tableaux, des graphiques et des diagrammes techniques, à partir de PDF, de diaporamas et d’autres types de documents.

Claude 3 peut analyser plusieurs images en une seule requête (jusqu’à un maximum de 20), ce qui lui permet de comparer et de contraster des images avec d’autres. Cela lui permet de comparer et de contraster des images, note Anthropic.

Mais le traitement d’images de Claude 3 a ses limites.

Anthropic a empêché les modèles d’identifier des personnes, sans doute en raison des implications éthiques et juridiques. L’entreprise admet que Claude 3 a tendance à commettre des erreurs avec des images de « faible qualité » (moins de 200 pixels) et qu’il éprouve des difficultés dans les tâches impliquant un raisonnement spatial (par exemple, la lecture d’un cadran d’horloge analogique) et le comptage d’objets (Claude 3 ne peut pas donner le nombre exact d’objets dans les images).

Crédits images : Anthropique

Claude 3 ne le fera pas non plus générer des œuvres d’art. Les modèles ne servent qu’à l’analyse d’images – du moins pour l’instant.

Qu’il s’agisse de texte ou d’images, Anthropic indique que les clients peuvent généralement s’attendre à ce que Claude 3 suive mieux les instructions en plusieurs étapes, produise des résultats structurés dans des formats tels que JSON et converse dans des langues autres que l’anglais, par rapport à ses prédécesseurs. Claude 3 devrait également refuser moins souvent de répondre aux questions grâce à une « compréhension plus nuancée des demandes », selon Anthropic. Et bientôt, les modèles citeront la source de leurs réponses aux questions afin que les utilisateurs puissent les vérifier.

« Claude 3 tend à générer des réponses plus expressives et engageantes », écrit Anthropic dans un article de soutien. « Il est plus facile à guider et à diriger que nos anciens modèles. Les utilisateurs devraient constater qu’ils peuvent obtenir les résultats souhaités avec des messages plus courts et plus concis.

Certaines de ces améliorations découlent du contexte élargi de Claude 3.

Le contexte d’un modèle, ou fenêtre de contexte, fait référence aux données d’entrée (par exemple du texte) que le modèle prend en compte avant de générer des résultats. Les modèles dotés d’une petite fenêtre contextuelle ont tendance à « oublier » le contenu de conversations même très récentes, ce qui les amène à s’écarter du sujet, souvent de manière problématique. En outre, les modèles à contexte large peuvent mieux saisir le flux narratif des données qu’ils reçoivent et générer des réponses plus riches en contexte (hypothétiquement, du moins).

Anthropic indique que Claude 3 prendra initialement en charge une fenêtre contextuelle de 200 000 mots, ce qui équivaut à environ 150 000 mots, et que certains clients pourront bénéficier d’une fenêtre contextuelle de 1 million de mots (environ 700 000 mots). Ce chiffre est comparable à celui du dernier modèle GenAI de Google, Gemini 1.5 Pro, mentionné plus haut, qui offre également une fenêtre contextuelle d’un million de mots.

Ce n’est pas parce que Claude 3 est une amélioration par rapport à ce qui l’a précédé qu’il est parfait.

Dans un livre blanc technique, Anthropic admet que Claude 3 n’est pas à l’abri des problèmes qui affectent les autres modèles de GenAI, à savoir les biais et les hallucinations (c’est-à-dire le fait d’inventer des choses). Contrairement à certains modèles de GenAI, Claude 3 ne peut pas faire de recherches sur le web ; les modèles ne peuvent répondre à des questions qu’en utilisant des données antérieures à août 2023. Et si Claude est multilingue, il ne maîtrise pas aussi bien certaines langues « à faibles ressources » que l’anglais.

Anthropic promet de fréquentes mises à jour de Claude 3 dans les mois à venir.

« Nous ne pensons pas que l’intelligence des modèles soit proche de ses limites, et nous prévoyons de publier des améliorations pour la famille de modèles Claude 3 au cours des prochains mois », écrit l’entreprise dans un billet de blog.

Opus et Sonnet sont disponibles dès à présent sur le web et via la console de développement et l’API d’Anthropic, la plateforme Bedrock d’Amazon et Vertex AI de Google. Haiku suivra plus tard dans l’année.

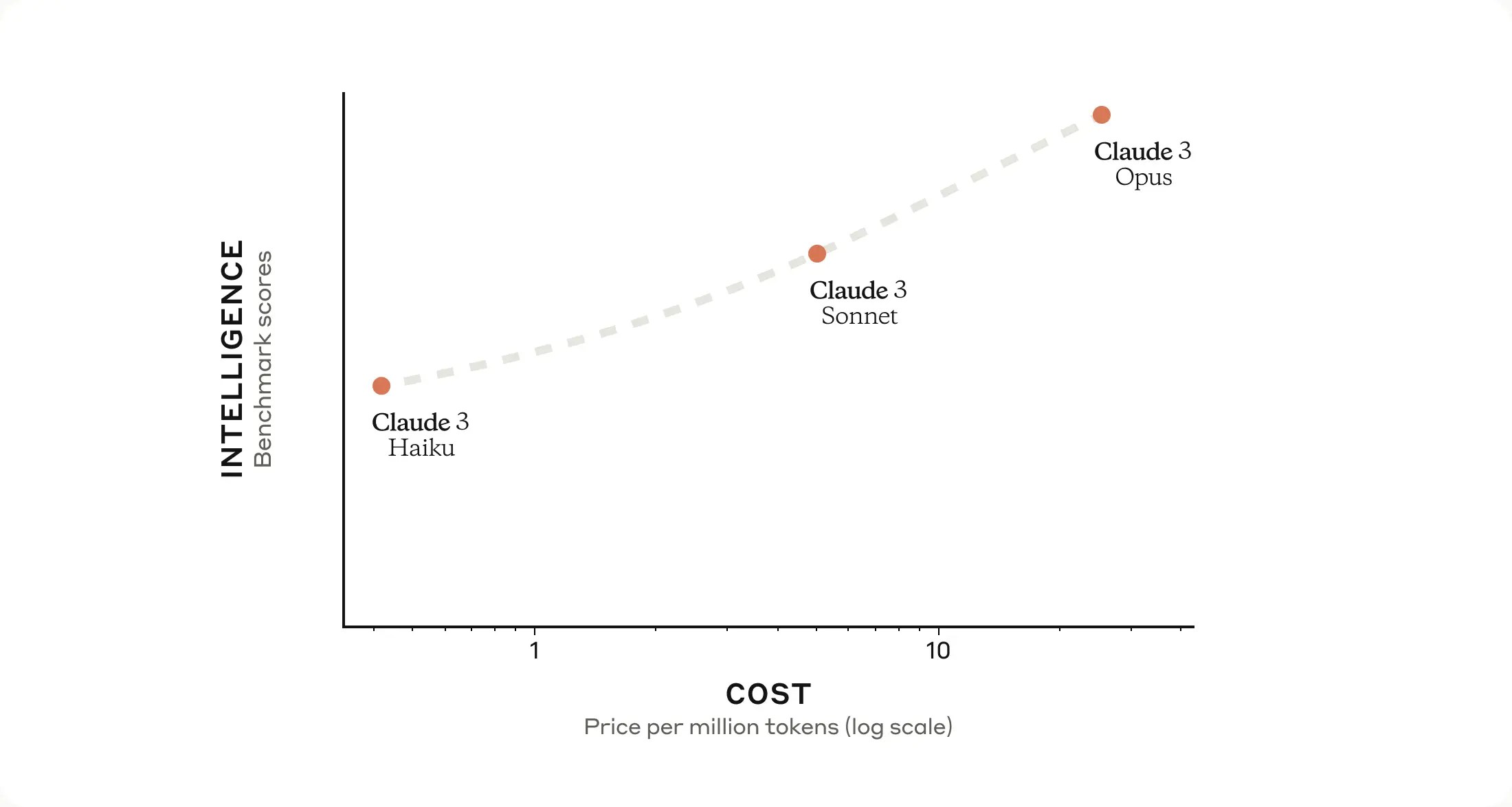

Voici la grille tarifaire :

- Opus : 15 dollars par million de jetons d’entrée, 75 dollars par million de jetons de sortie

- Sonnet : 3 $ par million de jetons d’entrée, 15 $ par million de jetons de sortie

- Haïku : 0,25 $ par million de jetons d’entrée, 1,25 $ par million de jetons de sortie

Voilà pour Claude 3. Mais quelle est la vision à 30 000 pieds de tout cela ?

Eh bien, comme nous l’avons rapporté l’ambition d’Anthropic est de créer un algorithme de nouvelle génération pour « l’auto-apprentissage de l’IA ». Un tel algorithme pourrait être utilisé pour créer des assistants virtuels capables de répondre aux courriels, d’effectuer des recherches et de créer des œuvres d’art, des livres et bien d’autres choses encore. GPT-4 et d’autres grands modèles linguistiques.

Anthropic y fait allusion dans le billet de blog susmentionné, en disant qu’il prévoit d’ajouter des fonctionnalités à Claude 3 qui améliorent ses capacités en permettant à Claude d’interagir avec d’autres systèmes, de coder « interactivement » et de fournir des « capacités agentiques avancées ».

Ce dernier point rappelle les ambitions déclarées d’OpenAI de créer un agent logiciel pour automatiser des tâches complexes, comme le transfert de données d’un document vers une feuille de calcul ou le remplissage automatique de notes de frais et leur saisie dans un logiciel de comptabilité. OpenAI propose déjà une API qui permet aux développeurs d’intégrer des « expériences de type agent » dans leurs applications, et il semble qu’Anthropic ait l’intention de proposer des fonctionnalités comparables.

Anthropic pourrait-il proposer un générateur d’images ? Franchement, cela me surprendrait. Les générateurs d’images font l’objet de nombreuses controverses ces derniers temps, principalement pour des raisons liées aux droits d’auteur et aux préjugés. Google a récemment été contraint de désactiver son générateur d’images après qu’il ait injecté de la diversité dans des images en faisant fi du contexte historique. Par ailleurs, un certain nombre de fournisseurs de générateurs d’images sont engagés dans des batailles juridiques avec des artistes qui les accusent de tirer profit de leur travail en entraînant GenAI sur ce travail sans leur fournir de compensation ou même de crédit.

Je suis curieux de voir l’évolution de la technique d’Anthropic pour l’entraînement des GenAI, l' »IA constitutionnelle », qui, selon l’entreprise, rend le comportement de ses GenAI plus facile à comprendre, plus prévisible et plus simple à ajuster en fonction des besoins. L’IA constitutionnelle vise à aligner l’IA sur les intentions humaines, en faisant en sorte que les modèles répondent à des questions et exécutent des tâches en utilisant un simple ensemble de principes directeurs. Par exemple, pour Claude 3, Anthropic a déclaré avoir ajouté un principe – informé par les commentaires de la foule – qui demande aux modèles d’être compréhensifs et accessibles aux personnes handicapées.

Quel que soit l’objectif final d’Anthropic, il s’agit d’un projet à long terme. Selon une présentation divulguée en mai de l’année dernière, l’entreprise vise à lever jusqu’à 5 milliards de dollars au cours des 12 prochains mois, ce qui pourrait bien être la base dont elle a besoin pour rester compétitive par rapport à OpenAI. (Elle est en bonne voie, avec 2 et 4 milliards de dollars de capital engagé et de promesses de dons de la part de Google et d’Amazon, respectivement, et plus d’un milliard de dollars de la part d’autres bailleurs de fonds.