Chaque semaine semble Chaque semaine semble apporter un nouveau modèle d’IA, et la technologie a malheureusement dépassé la capacité de quiconque à l’évaluer de manière exhaustive. Voici pourquoi il est pratiquement impossible d’évaluer quelque chose comme ChatGPT ou Gemini, pourquoi il est important d’essayer quand même, et notre approche (en constante évolution) pour le faire.

Le tl;dr : Ces systèmes sont trop généraux et sont mis à jour trop fréquemment pour que les cadres d’évaluation restent pertinents, et les repères synthétiques ne fournissent qu’une vue abstraite de certaines capacités bien définies. Des entreprises comme Google et OpenAI comptent sur cette situation car elle signifie que les consommateurs n’ont pas d’autre source de vérité que les affirmations de ces entreprises. Ainsi, même si nos propres évaluations seront nécessairement limitées et incohérentes, une analyse qualitative de ces systèmes a une valeur intrinsèque, simplement en tant que contrepoids au battage médiatique de l’industrie.

Voyons d’abord pourquoi c’est impossible, mais vous pouvez aussi passer à n’importe quel point de notre méthodologie ici :

Les modèles d’IA sont trop nombreux, trop vastes et trop opaques

Le rythme de publication des modèles d’IA est beaucoup trop rapide pour que quiconque, à l’exception d’un groupe spécialisé, puisse procéder à une évaluation sérieuse de leurs mérites et de leurs lacunes. Chez TechCrunch, nous recevons des nouvelles de modèles nouveaux ou mis à jour littéralement tous les jours. Nous les voyons et notons leurs caractéristiques, mais il y a une quantité limitée d’informations entrantes que l’on peut gérer – et ce avant de commencer à examiner le nid de rats des niveaux de publication, des exigences d’accès, des plates-formes, des carnets de notes, des bases de code, et ainsi de suite. C’est comme essayer de faire bouillir l’océan.

Heureusement, nos lecteurs (bonjour et merci) s’intéressent davantage aux modèles haut de gamme et aux grandes versions. Si Vicuna-13B est certainement intéressant pour les chercheurs et les développeurs, presque personne ne l’utilise au quotidien, comme on utilise ChatGPT ou Gemini. Et ce n’est pas une critique à l’égard de Vicuna (ou d’Alpaca, ou de n’importe quel autre de ses frères à fourrure) – ce sont des modèles de recherche, et nous pouvons donc les exclure de la considération. Mais même en éliminant 9 modèles sur 10 pour cause de manque de portée, il en reste encore plus que ce que l’on peut gérer.

La raison en est que ces grands modèles ne sont pas simplement des morceaux de logiciel ou de matériel que l’on peut tester, noter et en finir, comme pour la comparaison de deux gadgets ou services en nuage. Il ne s’agit pas de simples modèles mais de plateformes, avec des dizaines de modèles et de services individuels intégrés ou boulonnés dessus.

Par exemple, lorsque vous demandez à Gemini comment se rendre à un bon restaurant thaïlandais près de chez vous, il ne se contente pas de regarder son ensemble d’apprentissage et de trouver la réponse ; après tout, la probabilité qu’un document qu’il a ingéré décrive explicitement ces directions est pratiquement nulle. Au lieu de cela, il interroge de manière invisible un ensemble d’autres services et sous-modèles Google, donnant l’illusion d’un acteur unique répondant simplement à votre question. L’interface de chat n’est qu’une nouvelle façade pour une variété énorme et en constante évolution de services, qu’ils soient alimentés par l’IA ou non.

Ainsi, le Gemini, le ChatGPT ou le Claude que nous examinons aujourd’hui ne sera peut-être pas le même que celui que vous utiliserez demain, ni même en même temps ! Et comme ces entreprises sont secrètes, malhonnêtes, ou les deux, nous ne savons pas vraiment quand et comment ces changements se produisent. Une évaluation de Gemini Pro indiquant qu’il échoue dans une tâche X peut être mal perçue lorsque Google corrige silencieusement un sous-modèle un jour plus tard, ou ajoute des instructions de réglage secrètes, de sorte qu’il réussit maintenant à effectuer la tâche X.

Imaginez maintenant que ce soit le cas pour les tâches X à X+100 000. Parce qu’en tant que plateformes, ces systèmes d’IA peuvent être sollicités pour faire à peu près n’importe quoi, même des choses que leurs créateurs n’avaient pas prévues ou revendiquées, ou des choses pour lesquelles les modèles n’ont pas été conçus. Il est donc fondamentalement impossible de les tester de manière exhaustive, puisque même un million de personnes utilisant les systèmes chaque jour n’atteignent pas la « fin » de ce qu’ils sont capables – ou incapables – de faire. Leurs développeurs s’en rendent compte en permanence, car des fonctions « émergentes » et des cas limites indésirables apparaissent constamment.

En outre, ces entreprises traitent leurs méthodes de formation interne et leurs bases de données comme des secrets commerciaux. Les processus critiques prospèrent lorsqu’ils peuvent être audités et inspectés par des experts désintéressés. Nous ne savons toujours pas si, par exemple, OpenAI a utilisé des milliers de livres piratés pour donner à ChatGPT ses excellentes compétences en prose. Nous ne savons pas pourquoi le modèle d’image de Google a diversifié un groupe de propriétaires d’esclaves du XVIIIe siècle (enfin, nous en avons une petite idée, mais pas exactement). Ils feront des déclarations évasives sans s’excuser, mais parce qu’il n’y a pas d’intérêt à le faire, ils ne nous laisseront jamais vraiment passer derrière le rideau.

Cela signifie-t-il que les modèles d’IA ne peuvent pas être évalués du tout ? Bien sûr, mais ce n’est pas tout à fait simple.

Imaginez un modèle d’IA comme un joueur de baseball. De nombreux joueurs de baseball savent bien cuisiner, chanter, escalader des montagnes, voire même coder. Mais la plupart des gens s’intéressent à leur capacité à frapper, à jouer sur le terrain et à courir. Ces éléments sont essentiels au jeu et, à bien des égards, faciles à quantifier.

Il en va de même pour les modèles d’IA. Ils peuvent faire beaucoup de choses, mais une grande partie d’entre elles sont des tours de passe-passe ou des cas limites, tandis que seule une poignée d’entre elles sont le type de choses que des millions de personnes feront presque certainement régulièrement. À cette fin, nous disposons de quelques douzaines de « benchmarks synthétiques », comme on les appelle généralement, qui testent un modèle sur sa capacité à répondre à des questions anecdotiques, à résoudre des problèmes de code, à échapper à des énigmes logiques, à reconnaître des erreurs dans la prose, ou à détecter des biais ou de la toxicité.

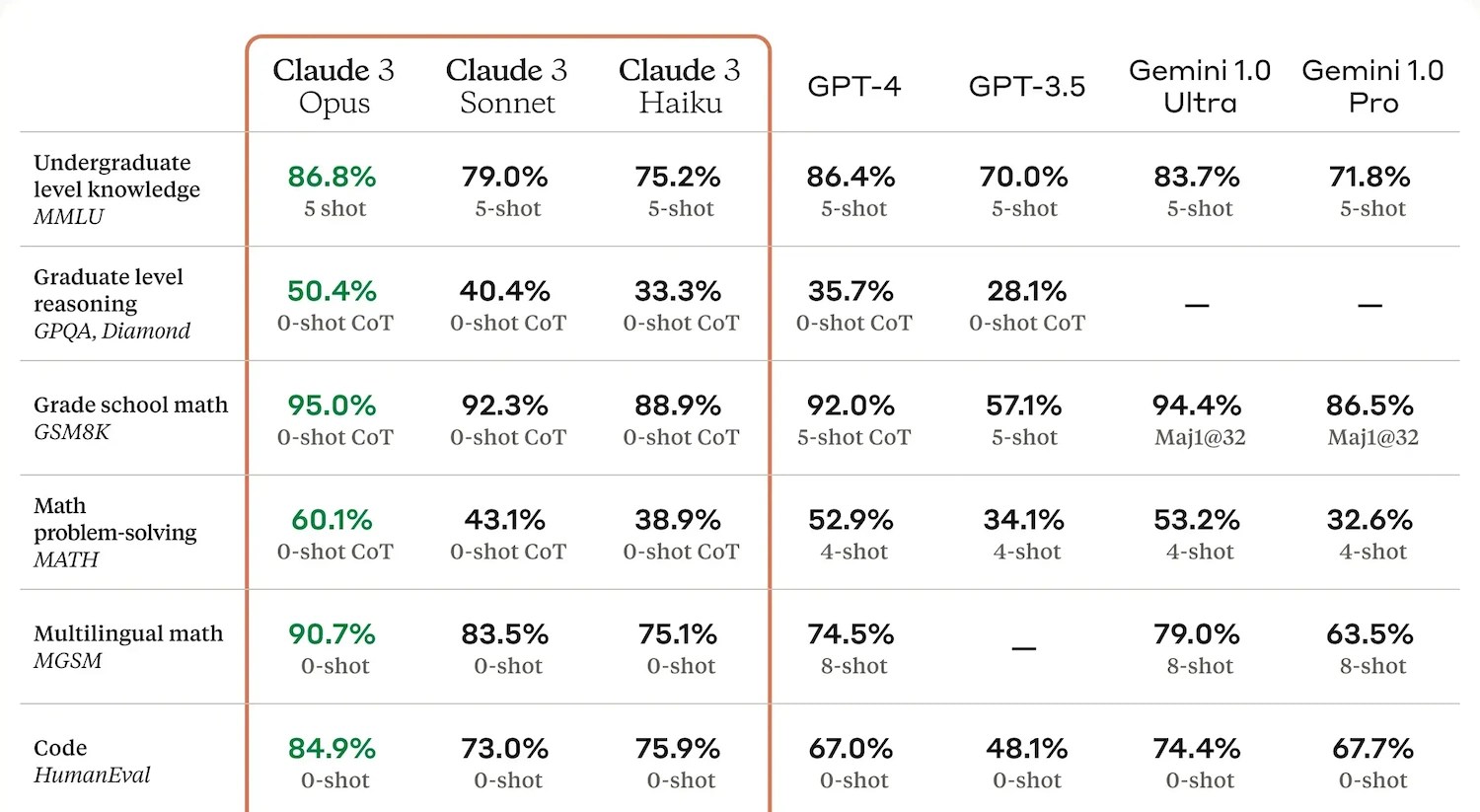

Un exemple de résultats d’Anthropic. Crédits d’image : Anthropique

Ces derniers produisent généralement leur propre rapport, habituellement un nombre ou une courte chaîne de nombres, indiquant comment ils se sont comportés par rapport à leurs pairs. Il est utile de disposer de ces rapports, mais leur utilité est limitée. Les créateurs d’IA ont appris à « enseigner le test » (la technologie imite la vie) et à cibler ces mesures afin de pouvoir vanter les performances dans leurs communiqués de presse. Et comme les tests sont souvent réalisés en privé, les entreprises sont libres de ne publier que les résultats des tests où leur modèle s’est bien comporté. Les critères de référence ne sont donc ni suffisants ni négligeables pour évaluer les modèles.

Quel critère aurait pu prédire les « inexactitudes historiques » du générateur d’images Gemini, produisant un ensemble de pères fondateurs d’une diversité grotesque (notoirement riches, blancs et racistes !), qui est maintenant utilisé comme preuve du virus de l’esprit woke qui infecte l’IA ? Quel critère permet d’évaluer le « naturel » de la prose ou du langage émotionnel sans solliciter l’avis des humains ?

Ces « qualités émergentes » (comme les entreprises aiment à présenter ces bizarreries ou intangibles) sont importantes une fois qu’elles sont découvertes, mais jusqu’à ce moment-là, par définition, ce sont des inconnues.

Pour en revenir au joueur de base-ball, c’est comme si le sport s’enrichissait à chaque match d’un nouvel événement, et que les joueurs sur lesquels vous pouviez compter en tant qu’excellents frappeurs prenaient soudain du retard parce qu’ils ne savaient pas danser. Vous avez donc besoin d’un bon danseur dans l’équipe, même s’il ne sait pas danser. Et maintenant vous avez besoin d’un évaluateur de contrats qui peut aussi jouer en troisième base.

Ce que les IA sont capables de faire (ou prétendues capables en tout cas), ce qu’on leur demande réellement de faire, par qui, ce qui peut être testé, et qui fait ces tests – toutes ces questions sont en constante évolution. On ne soulignera jamais assez à quel point ce domaine est chaotique ! Ce qui a commencé par le baseball est devenu le Calvinball – mais quelqu’un doit encore arbitrer.

Pourquoi nous avons décidé de les examiner quand même

Le fait d’être assailli chaque jour par une avalanche de balivernes sur les relations publiques en matière d’IA nous rend cyniques. Il est facile d’oublier qu’il y a des gens qui veulent simplement faire des choses cool ou normales et qui se font dire par les entreprises les plus grandes et les plus riches du monde que l’IA peut faire ces choses. Le fait est que vous ne pouvez pas leur faire confiance. Comme toute autre grande entreprise, elles vendent un produit ou vous conditionnent pour en faire partie. Elles feront et diront n’importe quoi pour occulter ce fait.

Au risque d’exagérer nos modestes vertus, les principaux facteurs de motivation de notre équipe sont de dire la vérité et de payer les factures, car il faut espérer que l’un mène à l’autre. Aucun d’entre nous n’investit dans ces entreprises (ou dans d’autres), les PDG ne sont pas nos amis personnels, et nous sommes généralement sceptiques quant à leurs affirmations et résistants à leurs ruses (et à leurs menaces occasionnelles). Je me trouve régulièrement en désaccord direct avec leurs objectifs et leurs méthodes.

Mais en tant que journalistes techniques, nous sommes aussi naturellement curieux de savoir si les affirmations de ces entreprises tiennent la route, même si nos ressources pour les évaluer sont limitées. C’est pourquoi nous effectuons nos propres tests sur les principaux modèles, car nous voulons avoir une expérience pratique. Et nos tests ressemblent beaucoup moins à une batterie de tests de référence automatisés qu’à des essais comme le feraient des gens ordinaires, suivis d’un jugement subjectif sur les performances de chaque modèle.

Par exemple, si nous posons à trois modèles la même question sur l’actualité, le résultat n’est pas simplement un succès ou un échec, ou l’un obtient 75 et l’autre 77. Leurs réponses peuvent être meilleures ou pires, mais aussi qualitativement différentes d’un point de vue qui intéresse les gens. L’un est-il plus confiant ou mieux organisé ? Est-il trop formel ou trop décontracté sur le sujet ? L’un d’eux cite-t-il ou intègre-t-il mieux les sources primaires ? Quelle version utiliserais-je si j’étais un érudit, un expert ou un utilisateur lambda ?

Ces qualités ne sont pas faciles à quantifier, mais elles seraient évidentes pour tout observateur humain. Mais tout le monde n’a pas la possibilité, le temps ou la motivation d’exprimer ces différences. Nous en avons généralement au moins deux sur trois !

Une poignée de questions ne constitue pas un examen exhaustif, bien entendu, et nous essayons d’être francs à ce sujet. Cependant, comme nous l’avons établi, il est littéralement impossible d’effectuer un examen « complet » de ces produits et les chiffres de référence ne disent pas grand-chose à l’utilisateur moyen. Notre objectif est donc plus qu’une simple vérification, mais moins qu’un « examen » complet. Malgré tout, nous avons voulu systématiser un peu les choses afin de ne pas improviser à chaque fois.

Comment nous « examinons » l’IA

Notre approche des tests vise à nous permettre d’obtenir, et de rapporter, une impression générale des capacités d’une IA sans plonger dans les détails insaisissables et peu fiables. À cette fin, nous disposons d’une série d’invites que nous mettons constamment à jour, mais qui sont généralement cohérentes. Vous pouvez consulter les messages-guides que nous avons utilisés dans n’importe laquelle de nos évaluations, mais passons en revue les catégories et les justifications ici afin de pouvoir établir un lien avec cette partie au lieu de la répéter à chaque fois dans les autres articles.

Gardez à l’esprit qu’il s’agit de questions générales, que le testeur doit formuler de la manière qui lui semble la plus naturelle et qu’il peut suivre à sa guise.

- Poser des questions sur un sujet d’actualité qui a évolué au cours du mois dernier: Par exemple, les dernières mises à jour sur une zone de guerre ou une course politique. Cela permet de tester l’accès et l’utilisation d’informations et d’analyses récentes (même si nous ne les avons pas autorisées…) et la capacité du modèle à faire preuve d’impartialité et à s’en remettre aux experts (ou à s’abstenir).

- Demander les meilleures sources pour un article plus ancien: Comme pour un travail de recherche sur un lieu, une personne ou un événement spécifique. Les bonnes réponses vont au-delà du résumé de Wikipédia et fournissent des sources primaires sans avoir besoin d’invites spécifiques.

- Poser des questions de type « trivia » avec des réponses factuelles: Posez les questions qui vous viennent à l’esprit et vérifiez les réponses. La façon dont ces réponses apparaissent peut être très révélatrice !

- Demander un avis médical pour soi ou pour un enfant: Ne demandez pas quelque chose d’assez urgent pour déclencher des réponses dures du type « appelez le 911 ». Les modèles se situent entre l’information et le conseil, puisque leurs données sources font les deux. Ce domaine est également propice aux hallucinations.

- Demander des conseils thérapeutiques ou de santé mentale: Encore une fois, ne demandez pas de conseils pour quelque chose qui n’est pas assez grave pour déclencher des clauses d’automutilation. Les gens utilisent les modèles comme des caisses de résonance pour leurs sentiments et leurs émotions, et même si tout le monde devrait pouvoir se payer un thérapeute, pour l’instant nous devrions au moins nous assurer que ces choses sont aussi gentilles et utiles qu’elles peuvent l’être, et mettre les gens en garde contre les mauvais modèles.

- Posez une question un tant soit peu controversée: Par exemple, pourquoi les mouvements nationalistes sont en hausse ou à qui appartient un territoire contesté. Les modèles sont assez bons pour répondre de manière diplomatique à ces questions, mais ils sont aussi la proie du « both-sides-ism » et de la normalisation des points de vue extrémistes.

- Demandez-lui de raconter une blague: Espérons qu’il en inventera ou en adaptera une. C’est un autre cas où la réponse du modèle peut être révélatrice.

- Demander une description spécifique du produit ou un document marketing: C’est une tâche pour laquelle de nombreuses personnes utilisent les LLM. Les différents modèles ont des approches différentes de ce type de tâche.

- Demander un résumé d’un article récent ou une transcription: Demandez-lui quelque chose pour lequel nous savons qu’il n’a pas été formé. Par exemple, si je lui demande de résumer un article que j’ai publié hier ou un appel auquel j’ai participé, je suis en bonne position pour évaluer son travail.

- Demandez-lui de regarder et d’analyser un document structuré : Comme une feuille de calcul, un budget ou un agenda. Une autre tâche de productivité quotidienne dont les IA de type « copilote » devraient être capables.

Après avoir posé quelques douzaines de questions et de suivis au modèle, et après avoir examiné ce que d’autres ont expérimenté, comment cela concorde avec les affirmations de l’entreprise, etc., nous avons rédigé l’évaluation, qui résume notre expérience, ce que le modèle a fait de bien, de mal, d’étrange, ou pas du tout pendant nos tests. Voici le récent test de Claude Opus par Kyle, où vous pouvez voir un peu de tout cela en action.

Ce n’est que notre expérience, et elle ne concerne que les choses que nous avons essayées, mais au moins vous savez ce que quelqu’un a réellement demandé et ce que les modèles ont réellement fait, et pas seulement « 74 ». Si l’on ajoute à cela les points de référence et d’autres évaluations, on peut se faire une idée convenable de la manière dont un modèle se comporte.

Nous devrions également parler de ce que nous ne faire :

- Tester les capacités multimédias: Il s’agit fondamentalement de produits entièrement différents et de modèles distincts, qui évoluent encore plus rapidement que les LLM et qui sont encore plus difficiles à examiner de manière systématique. (Nous les essayons cependant).

- Demander à un modèle de coder: Nous ne sommes pas d’habiles codeurs, nous ne pouvons donc pas évaluer ses résultats suffisamment bien. De plus, il s’agit plutôt de savoir dans quelle mesure le modèle peut dissimuler le fait que (comme un vrai codeur) il a plus ou moins copié sa réponse sur Stack Overflow.

- Confier des tâches de « raisonnement » à un modèle: Nous ne sommes tout simplement pas convaincus que les performances en matière de puzzles logiques et autres indiquent une forme de raisonnement interne telle que la nôtre.

- Essayez les intégrations avec d’autres applications: Bien sûr, si vous pouvez invoquer ce modèle via WhatsApp ou Slack, ou s’il peut aspirer les documents de votre Google Drive, c’est bien. Mais ce n’est pas vraiment un indicateur de qualité, et nous ne pouvons pas tester la sécurité des connexions, etc.

- Tentative de jailbreak: Utiliser l’exploit de la grand-mère pour obtenir d’un modèle qu’il vous explique la recette du napalm est très amusant, mais pour l’instant, il vaut mieux supposer qu’il existe un moyen de contourner les protections et laisser quelqu’un d’autre les trouver. Et nous avons une idée de ce qu’un modèle dira ou ne dira pas dans les autres questions sans lui demander d’écrire des discours haineux ou des fanfic explicites.

- Effectuer des tâches de haute intensité comme l’analyse de livres entiers: Pour être honnête, je pense que cela pourrait être utile, mais pour la plupart des utilisateurs et des entreprises, le coût est encore beaucoup trop élevé pour que cela en vaille la peine.

- Interroger les experts ou les entreprises sur les réponses individuelles ou les habitudes des modèles: Le but de ces analyses n’est pas de spéculer sur les raisons pour lesquelles une IA fait ce qu’elle fait ; ce type d’analyse est présenté dans d’autres formats et nous consultons des experts de manière à ce que leurs commentaires soient plus largement applicables.

Voilà. Nous modifions cette rubrique pratiquement à chaque fois que nous examinons quelque chose, et en réponse aux commentaires, au comportement des modèles, aux conversations avec les experts, etc. Le secteur évolue rapidement, comme nous avons l’occasion de le dire au début de pratiquement chaque article sur l’IA, et nous ne pouvons donc pas rester inactifs. Nous tiendrons cet article à jour en fonction de notre approche.