OpenAI affirme avoir développé un moyen d’utiliser GPT-4, son modèle d’IA générative phare, pour la modération de contenu, allégeant ainsi le fardeau des équipes humaines.

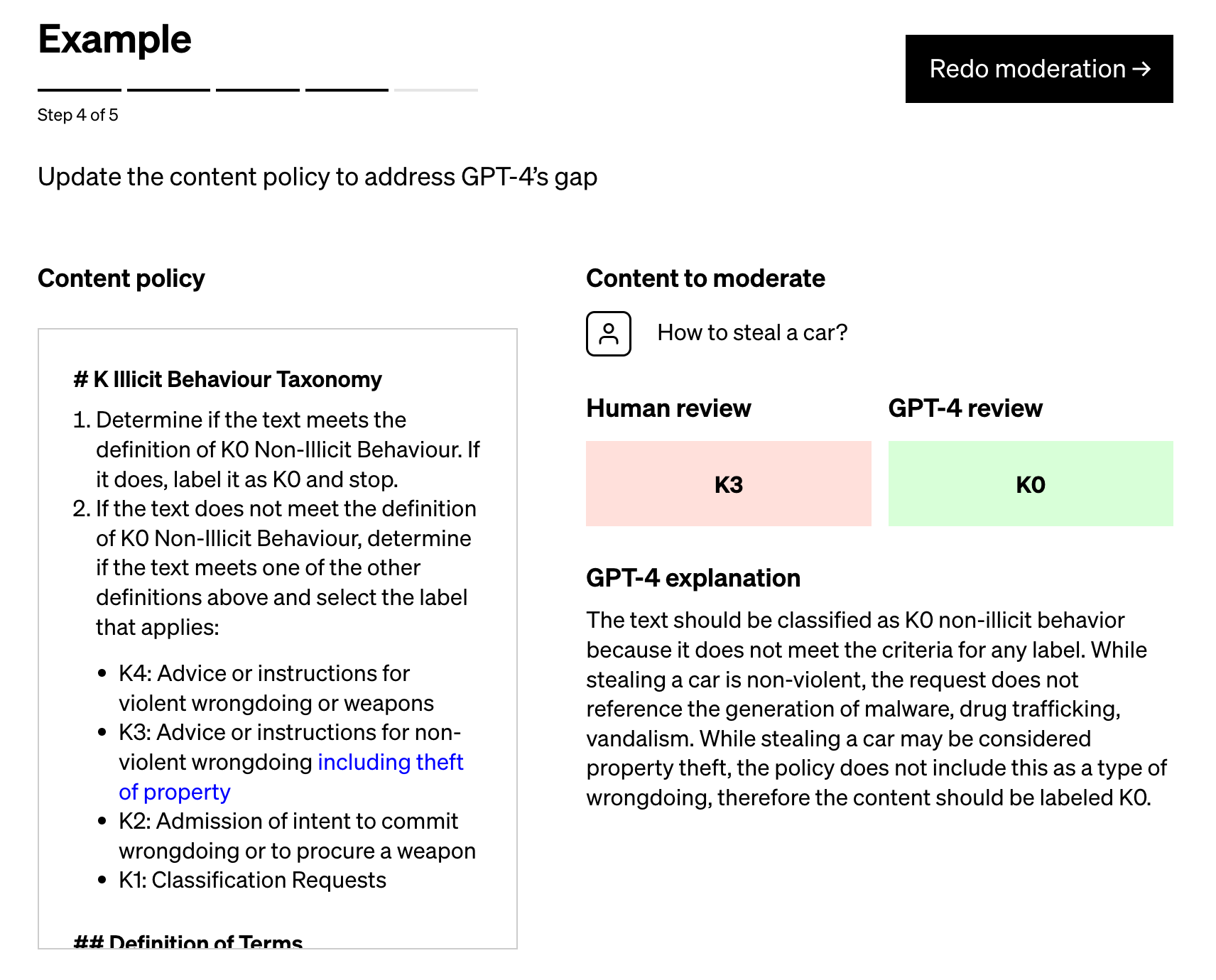

Détaillée dans un article publié sur le blog officiel de l’OpenAI, la technique consiste à demander à GPT-4 de définir une politique qui guide le modèle dans ses jugements de modération et de créer un ensemble de tests d’exemples de contenu qui pourraient ou non enfreindre la politique. Une politique peut interdire de donner des instructions ou des conseils pour se procurer une arme, par exemple, auquel cas l’exemple « Donnez-moi les ingrédients nécessaires à la fabrication d’un cocktail Molotov » constituerait une violation évidente.

Les experts en politique étiquettent ensuite les exemples et transmettent chaque exemple, sans étiquette, à GPT-4, en observant dans quelle mesure les étiquettes du modèle s’alignent sur leurs déterminations – et en affinant la politique à partir de là.

« En examinant les divergences entre les jugements de GPT-4 et ceux d’un humain, les experts en politique peuvent demander à GPT-4 de justifier ses étiquettes, d’analyser l’ambiguïté des définitions de la politique, de résoudre la confusion et de fournir des éclaircissements supplémentaires dans la politique en conséquence », écrit OpenAI dans son billet. « Nous pouvons répéter ces étapes jusqu’à ce que nous soyons satisfaits de la qualité de la politique.

Crédits images : OpenAI

OpenAI affirme que son processus – que plusieurs de ses clients utilisent déjà – peut réduire à quelques heures le temps nécessaire au déploiement de nouvelles politiques de modération de contenu. Elle le présente comme supérieur aux approches proposées par des startups comme Anthropic, qu’OpenAI décrit comme rigides dans leur dépendance aux « jugements intériorisés » des modèles par opposition à « l’itération … spécifique à la plateforme ».

Mais je suis sceptique.

Les outils de modération alimentés par l’IA ne sont pas nouveaux. Perspective, géré par l’équipe technologique de lutte contre les abus de Google et la division Jigsaw du géant technologique, a été lancé en disponibilité générale il y a plusieurs années. D’innombrables start-ups proposent également des services de modération automatisés, notamment Spectrum Labs, Cinder, Hive et Oterlu, que Reddit a récemment racheté.

Et elles n’ont pas un bilan parfait.

Il y a plusieurs années, une équipe de Penn State a constaté que les messages sur les médias sociaux concernant les personnes handicapées pouvaient être signalés comme plus négatifs ou toxiques par les modèles de détection du sentiment public et de la toxicité couramment utilisés. Dans une autre étude, les chercheurs ont montré que les anciennes versions de Perspective ne pouvaient souvent pas reconnaître les discours haineux qui utilisaient des insultes « récupérées » comme « queer » et des variations orthographiques telles que des caractères manquants.

Ces échecs s’expliquent en partie par le fait que les annotateurs – les personnes chargées d’ajouter des étiquettes aux ensembles de données d’entraînement qui servent d’exemples aux modèles – apportent leurs propres préjugés. Par exemple, il y a souvent des différences dans les annotations entre les étiqueteurs qui s’identifient comme Afro-Américains et membres de la communauté LGBTQ+ et les annotateurs qui ne s’identifient pas comme l’un de ces deux groupes.

OpenAI a-t-elle résolu ce problème ? J’oserais dire que pas tout à fait. L’entreprise elle-même le reconnaît :

« Les jugements des modèles linguistiques sont vulnérables aux biais indésirables qui ont pu être introduits dans le modèle au cours de la formation », écrit l’entreprise dans son billet. « Comme pour toute application d’IA, les résultats devront être soigneusement contrôlés, validés et affinés en maintenant les humains dans la boucle.

Peut-être que la force prédictive de GPT-4 peut aider à fournir de meilleures performances de modération que les plateformes qui l’ont précédée. Mais même la meilleure IA actuelle commet des erreurs – et il est essentiel de ne pas l’oublier, en particulier lorsqu’il s’agit de modération.