On dit souvent que les grands modèles de langage (LLM) tels que le ChatGPT d’OpenAI sont une boîte noire, et il y a certainement une part de vérité là-dedans. Même pour les scientifiques des données, il est difficile de savoir pourquoi un modèle réagit toujours de la manière dont il le fait, comme s’il inventait des faits de toutes pièces.

Dans le but d’éplucher les couches des LLM, OpenAI développe un outil permettant d’identifier automatiquement quelles parties d’un LLM sont responsables de tel ou tel de ses comportements. Les ingénieurs à l’origine de cet outil insistent sur le fait qu’il s’agit d’une première étape, mais le code permettant de le faire fonctionner est disponible en open source sur GitHub depuis ce matin.

« Nous essayons (de développer des moyens) d’anticiper les problèmes d’un système d’IA », a déclaré William Saunders, responsable de l’équipe d’interprétabilité d’OpenAI, lors d’un entretien téléphonique avec TechCrunch. « Nous voulons vraiment être en mesure de savoir si nous pouvons faire confiance à ce que le modèle fait et à la réponse qu’il produit.

À cette fin, l’outil d’OpenAI utilise un modèle de langage (ironiquement) pour déterminer les fonctions des composants d’autres LLM plus simples d’un point de vue architectural – en particulier le GPT-2 d’OpenAI.

L’outil d’OpenAI tente de simuler les comportements des neurones dans un LLM. Crédits image : OpenAI

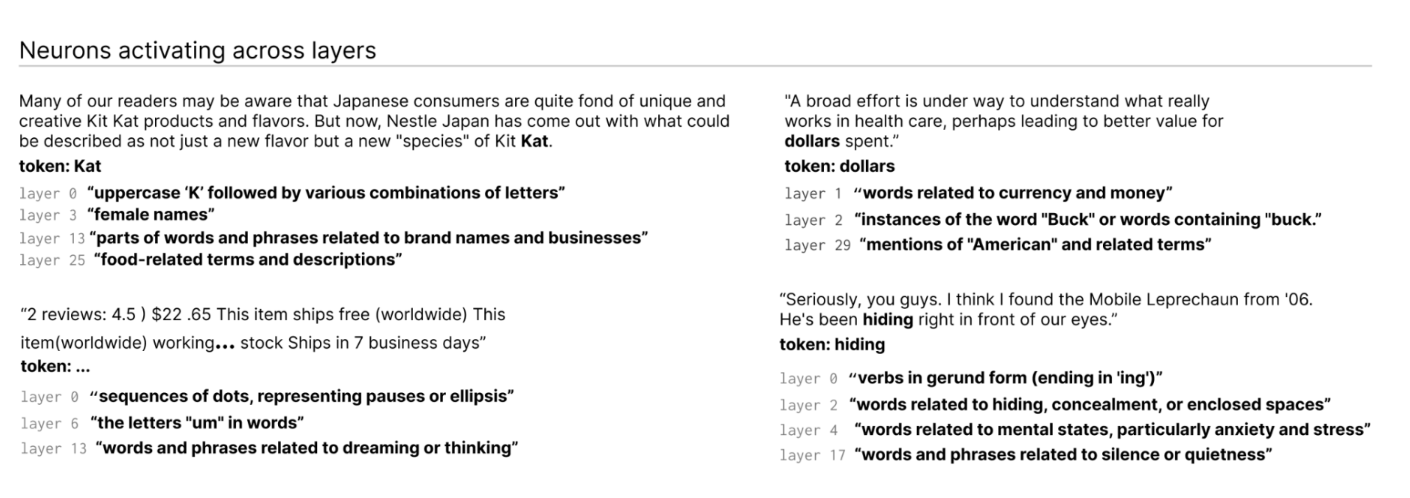

Comment ? Tout d’abord, une explication rapide sur les LLM. Comme le cerveau, ils sont constitués de « neurones » qui observent un modèle spécifique dans le texte afin d’influencer ce que le modèle global « dit » ensuite. Par exemple, dans le cas d’une question sur les super-héros (par exemple, « Quels super-héros ont les super-pouvoirs les plus utiles ? »), un « neurone super-héros Marvel » peut augmenter la probabilité que le modèle nomme des super-héros spécifiques des films Marvel.

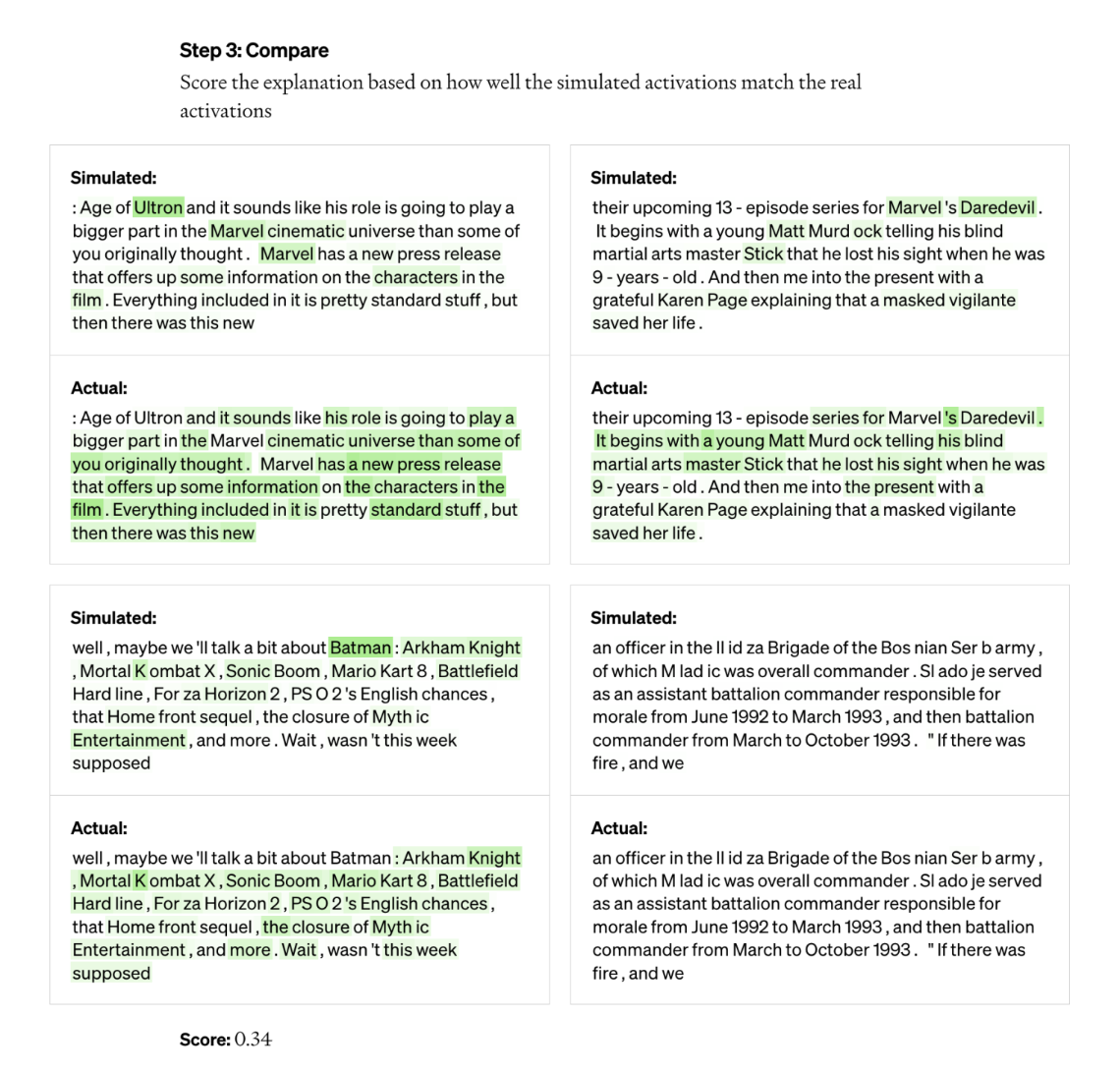

L’outil d’OpenAI exploite cette configuration pour décomposer les modèles en leurs éléments individuels. Tout d’abord, l’outil exécute des séquences de texte dans le modèle évalué et attend les cas où un neurone particulier « s’active » fréquemment. Ensuite, il « montre » à GPT-4, le dernier modèle d’IA génératrice de texte d’OpenAI, ces neurones très actifs et demande à GPT-4 de générer une explication. Pour déterminer la précision de l’explication, l’outil fournit à GPT-4 des séquences de texte et lui demande de prédire, ou de simuler, le comportement du neurone. Il compare ensuite le comportement du neurone simulé avec celui du neurone réel.

« En utilisant cette méthodologie, nous pouvons essentiellement, pour chaque neurone, fournir une sorte d’explication préliminaire en langage naturel de ce qu’il fait et obtenir un score pour déterminer dans quelle mesure cette explication correspond au comportement réel », a déclaré Jeff Wu, qui dirige l’équipe chargée de l’alignement évolutif au sein de l’OpenAI. « Nous utilisons GPT-4 dans le cadre de ce processus pour produire des explications sur ce qu’un neurone recherche, puis pour évaluer dans quelle mesure ces explications correspondent à la réalité de ce qu’il fait.

Les chercheurs ont pu générer des explications pour l’ensemble des 307 200 neurones du GPT-2, qu’ils ont compilées dans un ensemble de données publié en même temps que le code de l’outil.

Selon les chercheurs, des outils comme celui-ci pourraient un jour être utilisés pour améliorer les performances d’un LLM, par exemple pour réduire les biais ou la toxicité. Mais ils reconnaissent qu’il reste encore beaucoup de chemin à parcourir avant qu’ils ne soient réellement utiles. L’outil s’est montré confiant dans ses explications pour environ 1 000 de ces neurones, soit une petite fraction du total.

Une personne cynique pourrait également affirmer que l’outil est essentiellement une publicité pour GPT-4, étant donné qu’il a besoin de GPT-4 pour fonctionner. D’autres outils d’interprétabilité LLM sont moins dépendants des API commerciales, comme Tracr de DeepMind, un compilateur qui traduit les programmes en modèles de réseaux neuronaux.

Wu a déclaré que ce n’était pas le cas – le fait que l’outil utilise GPT-4 est simplement « accessoire » – et, au contraire, montre les faiblesses de GPT-4 dans ce domaine. Il a également indiqué que l’outil n’avait pas été créé en vue d’applications commerciales et qu’il pourrait, en théorie, être adapté pour utiliser d’autres LLM que le GPT-4.

L’outil identifie les neurones qui s’activent à travers les couches du LLM. Crédits images : OpenAI

« La plupart des explications obtiennent des résultats assez médiocres ou n’expliquent pas une grande partie du comportement du neurone réel », a déclaré M. Wu. « Un grand nombre de neurones, par exemple, sont actifs d’une manière telle qu’il est très difficile de dire ce qui se passe – comme s’ils s’activaient sur cinq ou six choses différentes, mais il n’y a pas de modèle discernable. Parfois, il y a est un modèle discernable, mais GPT-4 est incapable de le trouver ».

Sans parler des modèles plus complexes, plus récents et plus grands, ou des modèles capables de naviguer sur le web pour trouver des informations. Mais sur ce deuxième point, Wu pense que la navigation sur le web ne changerait pas beaucoup les mécanismes sous-jacents de l’outil. Il pourrait simplement être adapté, dit-il, pour comprendre pourquoi les neurones décident de faire certaines requêtes sur les moteurs de recherche ou d’accéder à certains sites web.

« Nous espérons que cela ouvrira une voie prometteuse pour aborder l’interprétabilité de manière automatisée, sur laquelle d’autres pourront se baser et contribuer », a déclaré M. Wu. « L’espoir est que nous ayons réellement de bonnes explications non seulement sur les réponses des neurones, mais aussi sur le comportement général de ces modèles – quels types de circuits ils calculent et comment certains neurones affectent d’autres neurones.