Gemini, le modèle d’IA générative de Google promis depuis longtemps, est arrivé. En quelque sorte.

La version de Gemini lancée cette semaine, Gemini Pro, est essentiellement une ramification légère d’un modèle Gemini plus puissant et plus performant qui devrait arriver… dans le courant de l’année prochaine. Mais je m’avance un peu.

Hier, lors d’une conférence de presse virtuelle, des membres de l’équipe Google DeepMind – la force motrice de Gemini, aux côtés de Google Research – ont donné une vue d’ensemble de Gemini (techniquement « Gemini 1.0 ») et de ses capacités.

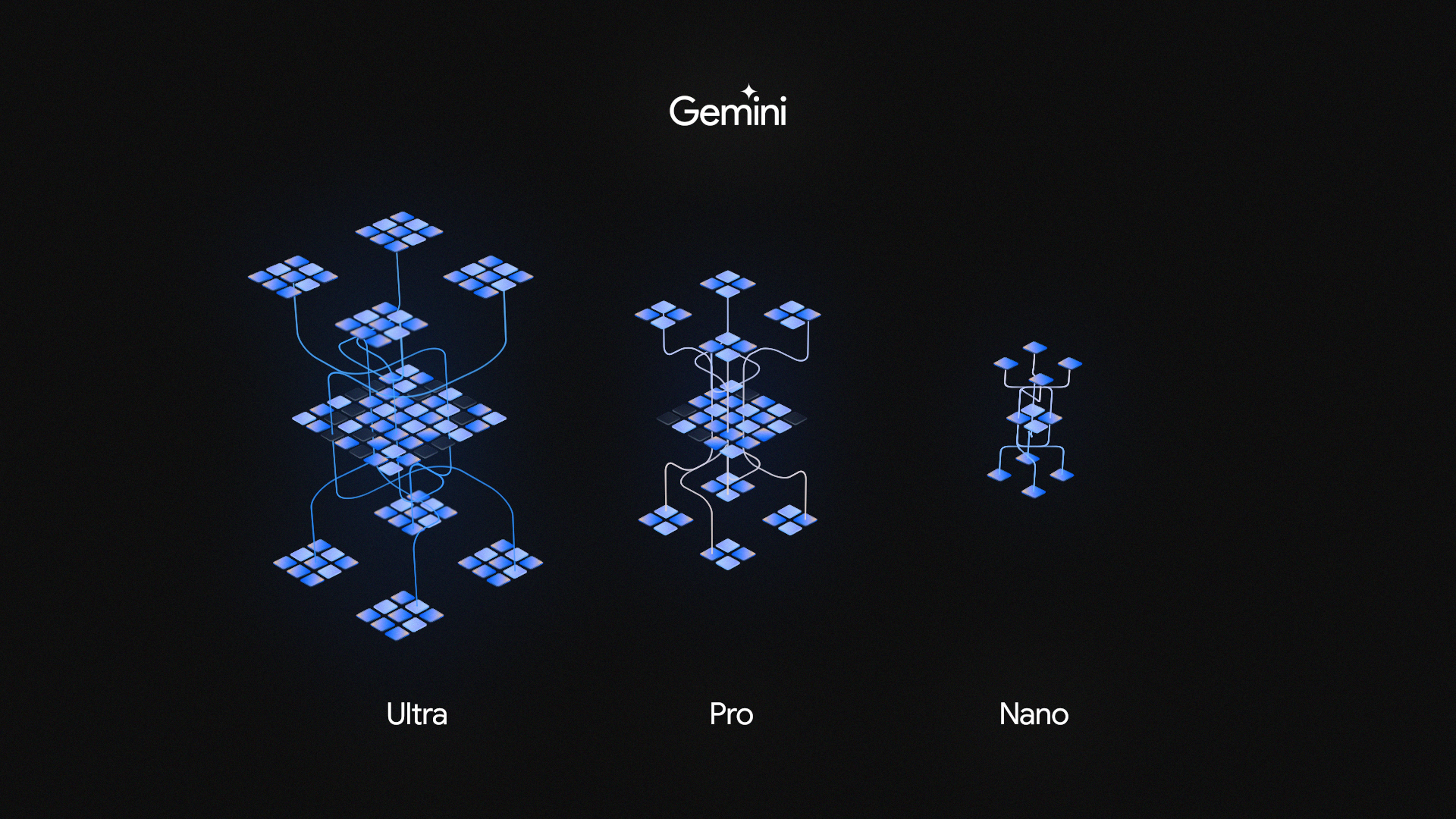

Il s’avère que Gemini est en fait une famille de modèles d’IA, et non un seul. Il se décline en trois versions :

- Gemini Ultra, le modèle phare de Gemini

- Gemini Pro, un modèle Gemini « allégé ».

- Gemini Nano, qui est distillé pour fonctionner sur des appareils mobiles comme le Pixel 8 Pro*.

*Pour rendre les choses plus confuses, Gemini Nano se décline en deux modèles, Nano-1 (1,8 milliard de paramètres) et Nano-2 (3,25 milliards de paramètres) – ciblant respectivement les appareils à faible mémoire et à mémoire élevée.

Crédits d’image : Google

L’endroit le plus facile pour essayer Gemini Pro est Bard, le concurrent ChatGPT de Google, qui, à partir d’aujourd’hui, est alimenté par une version affinée de Gemini Pro – au moins en anglais aux États-Unis (et seulement pour le texte, pas pour les images). Sissie Hsiao, directeur général de Google Assistant et de Bard, a déclaré lors de la réunion d’information que la version améliorée de Gemini Pro offrait de meilleures capacités de raisonnement, de planification et de compréhension que le modèle précédent de Bard.

Nous ne pouvons confirmer aucune de ces améliorations de manière indépendante. Google n’a pas autorisé les journalistes à tester les modèles avant leur présentation et n’a d’ailleurs pas fait de démonstrations en direct lors de la réunion d’information.

Gemini Pro sera également lancé le 13 décembre pour les entreprises utilisant Vertex AI, la plate-forme d’apprentissage automatique entièrement gérée par Google, puis la suite de développeurs Generative AI Studio de Google (certains utilisateurs attentifs ont déjà repéré des versions de modèles Gemini dans le jardin de modèles de Vertex AI). Par ailleurs, Gemini arrivera dans les mois à venir dans les produits Google tels que Duet AI, Chrome et Ads, ainsi que dans Search dans le cadre de la Search Generative Experience de Google.

Gemini Nano, quant à lui, sera bientôt lancé en avant-première via l’application AI Core récemment publiée par Google, exclusive à Android 14 sur le Pixel 8 Pro pour l’instant ; les développeurs Android intéressés par l’intégration du modèle dans leurs applications peuvent s’inscrire dès aujourd’hui pour un aperçu. Sur le Pixel 8 Pro d’abord et sur d’autres appareils Android à l’avenir, Gemini Nano alimentera des fonctionnalités que Google a présentées en avant-première lors du dévoilement du Pixel 8 Pro en octobre, comme le résumé dans l’app Enregistreur et les réponses suggérées pour les apps de messagerie prises en charge (à commencer par WhatsApp).

Nativement multimodal

Gemini Pro – ou du moins la version affinée de Gemini Pro qui équipe Bard – n’a pas grand-chose à se mettre sous la dent.

Selon M. Hsiao, Gemini Pro est plus performant dans des tâches telles que le résumé de contenu, le brainstorming et la rédaction, et surpasse le GPT-3.5 d’OpenAI, le prédécesseur du GPT-4, dans six tests de référence, dont l’un d’eux (GSM8K) qui mesure le raisonnement mathématique à l’école primaire. Mais le GPT-3.5 date de plus d’un an, ce qui n’est pas vraiment un défi à relever à ce stade.

Qu’en est-il de Gemini Ultra ? Il doit certainement être plus impressionnant ?

En partie.

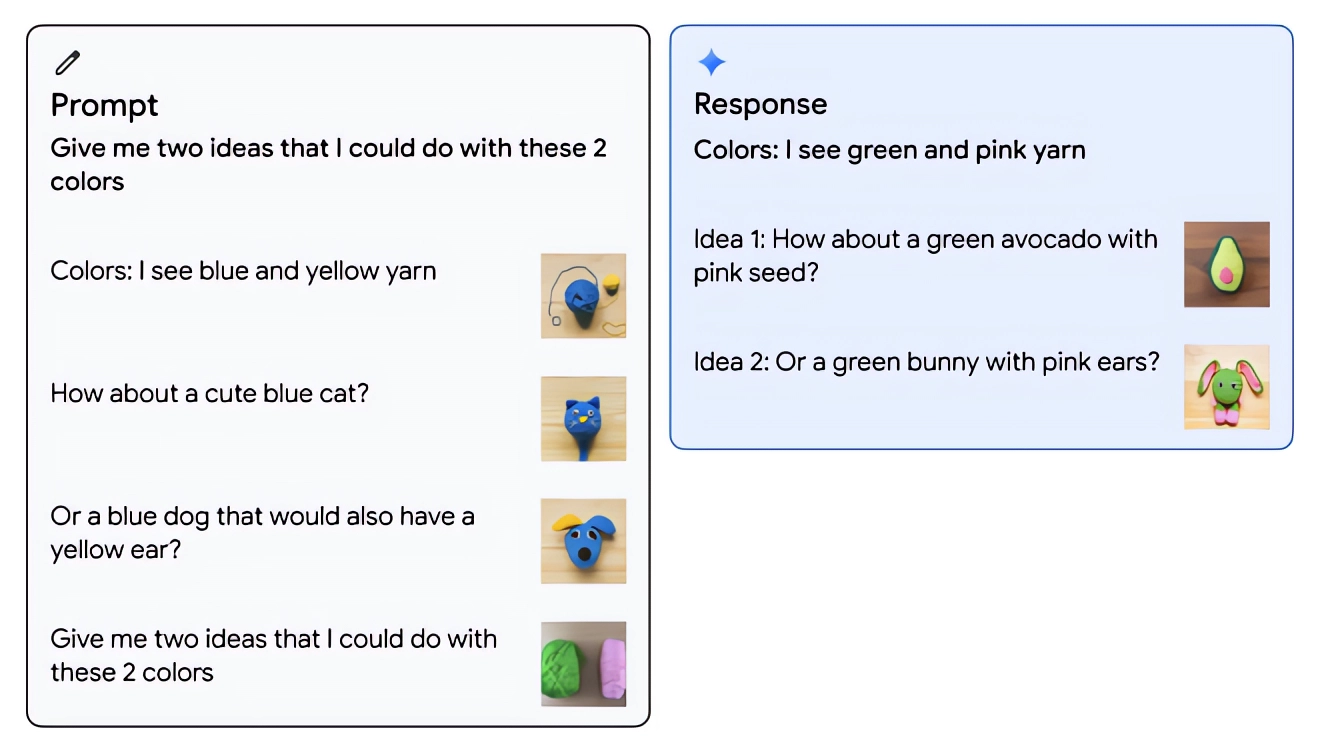

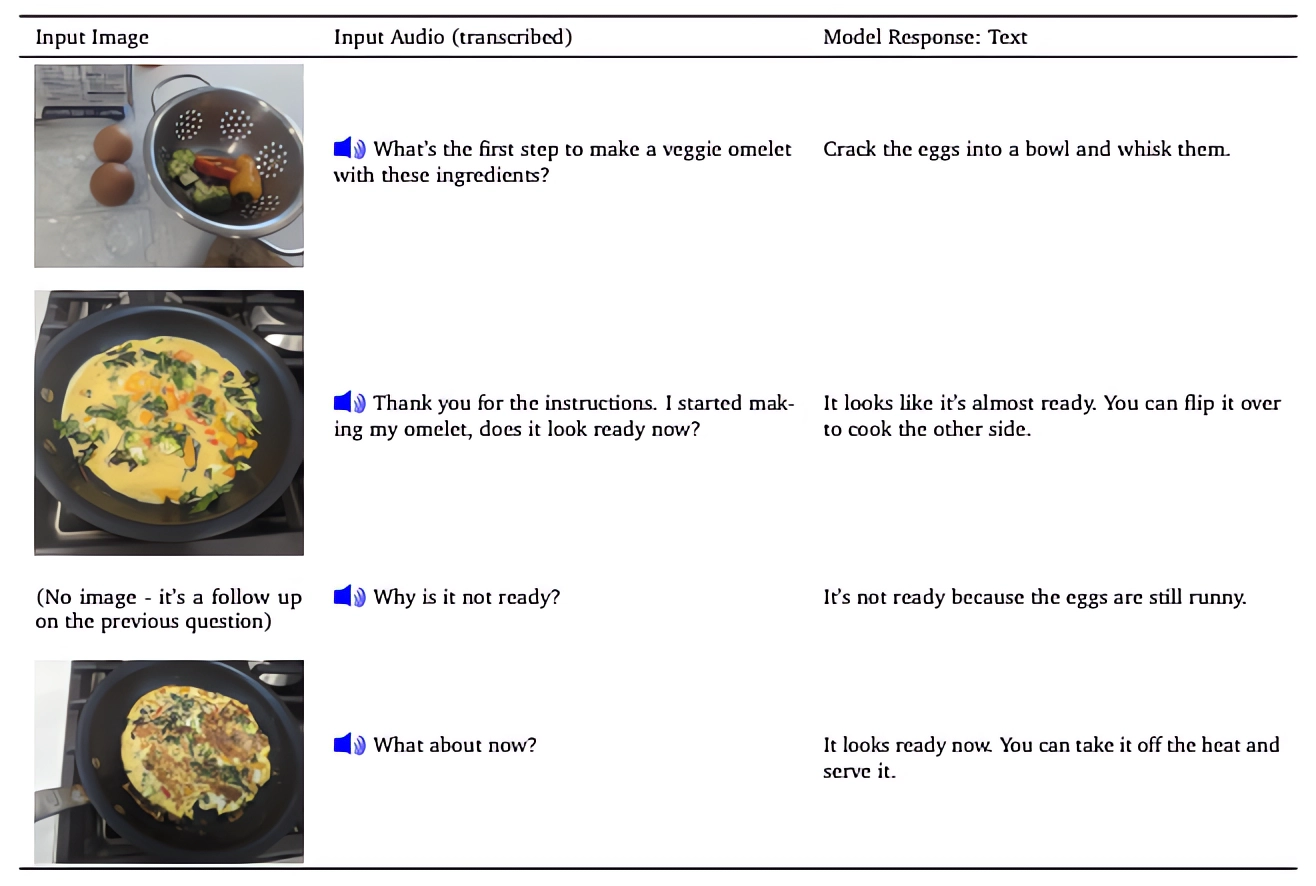

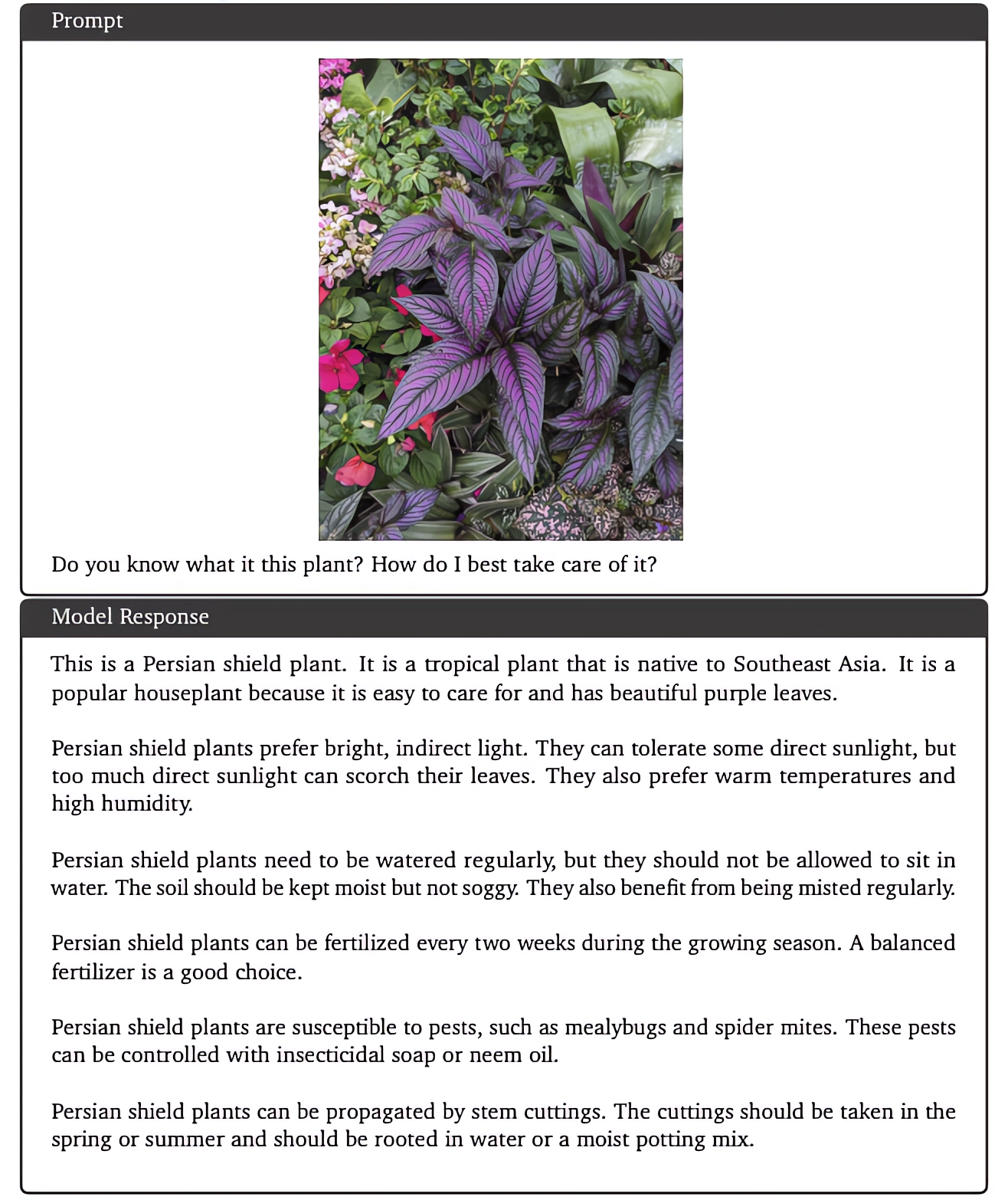

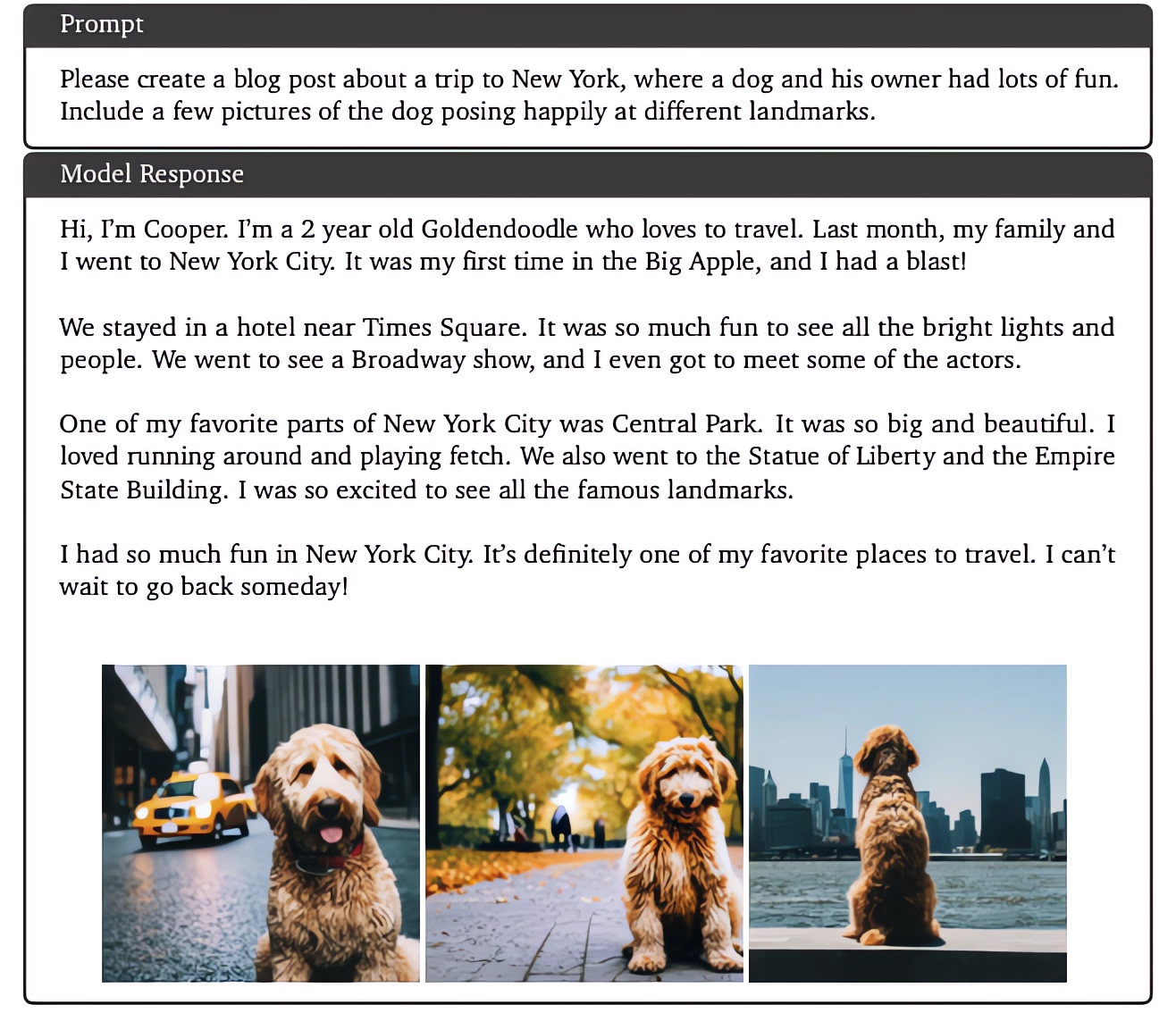

Comme Gemini Pro, Gemini Ultra a été entraîné pour être « nativement multimodal » – en d’autres termes, pré-entraîné et affiné sur un large ensemble de bases de code, de textes dans différentes langues, d’audio, d’images et de vidéos. Eli Collins, vice-président chargé des produits chez DeepMind, affirme que Gemini Ultra peut comprendre des informations « nuancées » dans du texte, des images, de l’audio et du code et répondre à des questions relatives à des sujets « compliqués », en particulier les mathématiques et la physique.

Crédits d’image : Google

À cet égard, Gemini Ultra fait plusieurs choses mieux que le modèle multimodal rival d’OpenAI, GPT-4 with Vision, qui ne peut comprendre que le contexte de deux modalités : les mots et les images. Gemini Ultra peut transcrire la parole et répondre à des questions sur des fichiers audio et vidéo (par exemple « Que se passe-t-il dans ce clip ? »), ainsi que sur des œuvres d’art et des photos.

« L’approche standard pour créer des modèles multimodaux consiste à former des composants distincts pour les différentes modalités », a déclaré M. Collins lors de la réunion d’information. « Ces modèles sont assez performants pour certaines tâches, comme la description d’une image, mais ils ont beaucoup de mal avec les tâches conceptuelles et de raisonnement plus compliquées. Nous avons donc conçu Gemini pour qu’il soit nativement multimodal ».

J’aimerais pouvoir vous en dire plus sur les ensembles de données de formation de Gemini – je suis moi-même curieux. Mais Google a refusé à plusieurs reprises de répondre aux questions des journalistes sur la manière dont il a collecté les données d’entraînement de Gemini, sur l’origine des données d’entraînement et sur le fait qu’une partie de ces données ait été concédée sous licence par un tiers.

Collins did a révélé qu’au moins une partie des données provenait de sources web publiques et que Google les avait « filtrées » pour en vérifier la qualité et le caractère « inapproprié ». Mais il n’a pas abordé la question de l’éléphant dans la pièce : les créateurs qui auraient contribué à leur insu aux données d’entraînement de Gemini peuvent-ils se retirer ou attendre/demander une compensation ?

Google n’est pas le premier à garder ses données de formation secrètes. Ces données ne constituent pas seulement un avantage concurrentiel, mais aussi une source potentielle de procès relatifs à l’utilisation équitable. Microsoft, GitHub, OpenAI et Stability AI font partie des fournisseurs d’IA générative poursuivis dans le cadre de requêtes qui les accusent de violer le droit de la propriété intellectuelle en entraînant leurs systèmes d’IA sur des contenus protégés par le droit d’auteur, notamment des œuvres d’art et des livres électroniques, sans en créditer les créateurs ni les rémunérer.

Crédits d’image : Google

OpenAI, rejoignant plusieurs autres fournisseurs d’IA générative, a récemment déclaré qu’elle permettrait aux artistes de se retirer des ensembles de données d’entraînement pour ses futurs modèles de génération d’œuvres d’art. Google n’offre aucune option de ce type pour les modèles générateurs d’art ou autres – et il semble que cette politique ne changera pas avec Gemini.

Google a entraîné Gemini sur ses propres puces d’IA, les unités de traitement tensoriel (TPU) – en particulier les TPU v4 et v5e (et à l’avenir la v5p) – et exécute les modèles Gemini sur une combinaison de TPU et de GPU. (Selon un livre blanc technique publié ce matin, l’entraînement de Gemini Pro a pris « quelques semaines », et celui de Gemini Ultra devrait prendre beaucoup plus de temps). Bien que Collins ait affirmé que Gemini est le grand modèle d’IA générative de Google « le plus efficace » à ce jour et « nettement moins cher » que ses prédécesseurs multimodaux, il n’a pas voulu dire combien de puces ont été utilisées pour l’entraîner, ni combien cela a coûté, ni l’impact de l’entraînement sur l’environnement.

Un article estime que la formation d’un modèle de la taille de GPT-4 émet plus de 15 tonnes de CO2 – équivalent aux émissions annuelles de près de 1 000 Américains. On peut espérer que Google a pris des mesures pour atténuer l’impact, mais comme l’entreprise a choisi de ne pas aborder la question – du moins pas au cours de la réunion d’information à laquelle ce journaliste a assisté – qui peut le dire ?

Un meilleur modèle – marginalement

Dans une démonstration préenregistrée, Google a montré comment Gemini pouvait être utilisé pour aider les élèves à faire leurs devoirs de physique, en résolvant les problèmes étape par étape sur une feuille de travail et en signalant les erreurs possibles dans les réponses déjà remplies.

Dans une autre démonstration – également préenregistrée – Gemini a permis d’identifier des articles scientifiques pertinents pour un problème particulier, d’extraire des informations de ces articles et de « mettre à jour » un graphique en générant les formules nécessaires pour recréer le graphique avec des données plus récentes.

Vous pouvez considérer ce travail comme une extension de ce que (DeepMind) a mis au point avec la « chaîne de pensée », c’est-à-dire qu’avec un réglage plus poussé des instructions, vous pouvez amener le modèle à suivre des instructions (plus complexes) », a déclaré M. Collins. « Si vous pensez à l’exemple du devoir de physique, vous pouvez donner au modèle une image mais aussi des instructions à suivre – par exemple, identifier la faille dans les mathématiques du devoir de physique. Le modèle est donc capable de traiter des instructions plus compliquées ».

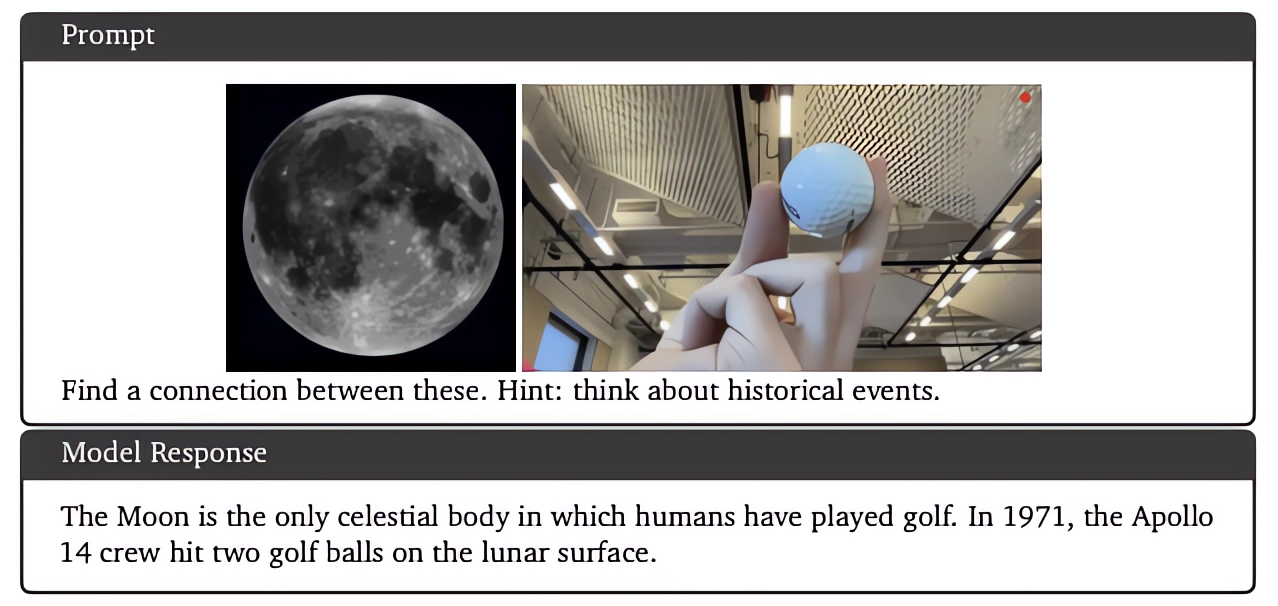

Collins a vanté à plusieurs reprises au cours de la réunion d’information la supériorité de Gemini Ultra en matière de benchmark, affirmant que le modèle dépasse les résultats actuels de l’état de l’art sur « 30 des 32 points de référence académiques largement utilisés dans la recherche et le développement de grands modèles de langage ». Mais si l’on se penche sur les résultats, il devient rapidement évident que Gemini Ultra n’obtient que des résultats légèrement supérieurs à ceux de GPT-4 et GPT-4 avec Vision pour bon nombre de ces points de référence.

Crédits d’image : Google

Par exemple, sur GSM8K, Gemini Ultra répond correctement à 94,4 % des questions de mathématiques, contre 92 % pour GPT-4. Sur le test DROP de compréhension de la lecture, Gemini Ultra devance à peine GPT-4, 82,4 % contre 80,9 %. Sur VQAv2, un test de compréhension d’images « neuronales », Gemini fait à peine 0,6 point de pourcentage de mieux que GPT-4 avec Vision. Et Gemini Ultra dépasse GPT-4 de seulement 0,5 point de pourcentage sur la suite de raisonnement Big-Bench Hard.

Collins note que Gemini Ultra atteint un score « de pointe » de 59,4 % sur un nouveau benchmark, MMMU, pour le raisonnement multimodal – devant GPT-4 avec Vision. Mais en un ensemble de tests pour le raisonnement de bon sens, HellaSwag, Gemini Ultra est en fait assez loin derrière GPT-4 avec un score de 87,8 % ; GPT-4 obtient 95,3 %.

Lorsqu’un journaliste lui a demandé si Gemini Ultra, comme d’autres modèles d’IA générative, était victime d’hallucinations – c’est-à-dire qu’il invente des faits en toute confiance – M. Collins a répondu qu’il ne s’agissait pas d’un problème de recherche résolu. Prenez cela comme vous l’entendez.

On peut supposer que les biais et la toxicité sont tout à fait envisageables pour Gemini Ultra, étant donné que même les meilleurs modèles d’IA générative actuels réagissent de manière problématique et nuisible lorsqu’ils sont sollicités d’une certaine manière. Il est presque certain qu’il est aussi anglocentrique que les autres modèles d’IA générative – Collins a déclaré que, bien que Gemini Ultra puisse traduire entre une centaine de langues, aucun travail spécifique n’a été effectué pour localiser le modèle dans les pays du Sud.

Crédits d’image : Google

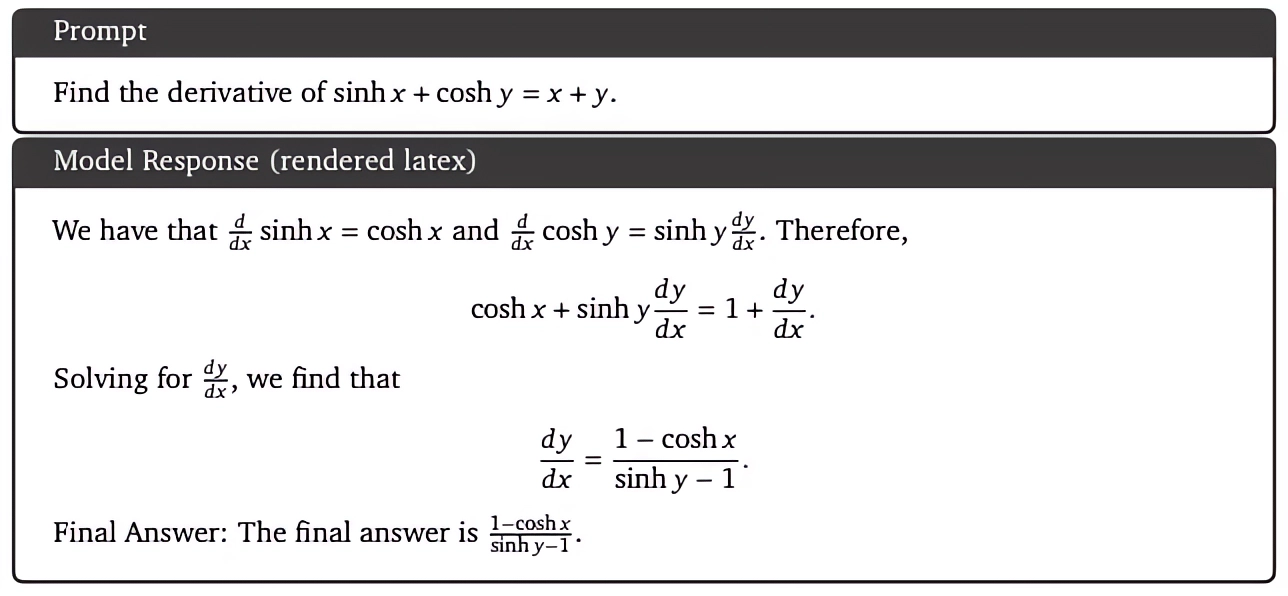

Autre limitation importante, bien que l’architecture Gemini Ultra prenne en charge la génération d’images (tout comme Gemini Pro, en théorie), cette capacité ne sera pas intégrée dans la version produite du modèle au moment du lancement. C’est peut-être parce que le mécanisme est légèrement plus complexe que la façon dont, par exemple, ChatGPT génère des images ; plutôt que d’envoyer des invites à un générateur d’images (comme DALL-E 3, dans le cas de ChatGPT), Gemini produit des images « en mode natif » sans étape intermédiaire.

Collins n’a pas fourni de calendrier quant à l’arrivée de la génération d’images, se contentant d’assurer que le travail est « en cours ».

Une sortie précipitée

L’impression qui se dégage du « lancement » de Gemini cette semaine est qu’il s’agissait d’un travail un peu précipité.

Lors de sa conférence annuelle I/O pour les développeurs, Google a promis que Gemini offrirait « des capacités multimodales impressionnantes, inédites dans les modèles précédents » et « l’efficacité des intégrations d’outils et d’API ». Dans une interview accordée à Wired en juin, Demis Hassabis, directeur et cofondateur de DeepMind, a décrit Gemini comme introduisant de nouvelles capacités dans le domaine de l’IA génératrice de texte, telles que la planification et la capacité à résoudre des problèmes.

Il se pourrait bien que Gemini Ultra soit capable de tout cela, et même plus. Mais la réunion d’information d’hier n’était pas particulièrement convaincante et, compte tenu des récents faux pas de Google en matière d’intelligence artificielle, je dirais qu’elle devait l’être.

Crédits d’image : Google

Google rattrape son retard dans le domaine de l’IA générative depuis le début de l’année, après l’OpenAI et la sensation virale ChatGPT de l’entreprise. Bard a été lancé en février et a été critiqué pour son incapacité à répondre correctement à des questions de base ; les employés de Google, y compris l’équipe d’éthique de l’entreprise, ont exprimé des inquiétudes quant à l’accélération du calendrier de lancement.

Il est apparu par la suite que Google avait engagé des sous-traitants d’Appen et d’Accenture, surchargés de travail et sous-payés, pour annoter les données d’entraînement de Bard. Il pourrait en être de même pour Gemini ; Google ne l’a pas nié hier, et le livre blanc technique indique seulement que les annotateurs ont été payés « au moins un salaire de subsistance local ».

Maintenant, pour être juste envers Google, il fait des progrès dans le sens où Bard s’est considérablement amélioré depuis son lancement et que Google a injecté avec succès des dizaines de ses produits, applications et services avec de nouvelles fonctionnalités génératives alimentées par l’IA, alimentées par des modèles maison tels que PaLM 2 et Imagen.

Mais les rapports suggèrent que le développement de Gemini a été perturbé.

Gemini – qui aurait bénéficié de la participation directe de hauts responsables de Google, dont Jeff Dean, le plus haut responsable de la recherche en IA de l’entreprise – rencontrerait des difficultés dans des tâches telles que le traitement fiable de requêtes en langue autre que l’anglais, ce qui a contribué à retarder le lancement de Gemini Ultra. (Gemini Ultra ne sera disponible que pour certains clients, développeurs, partenaires et « experts en sécurité et responsabilité » avant d’être déployé pour les développeurs et les entreprises clientes, puis pour Bard « au début de l’année prochaine », précise Google). Google ne comprend même pas encore toutes les nouvelles capacités de Gemini Ultra, a déclaré M. Collins, et n’a pas non plus élaboré de stratégie de monétisation pour Gemini. (Étant donné le coût élevé de la formation et de l’inférence des modèles d’IA, je ne pense pas qu’il faille attendre longtemps avant qu’il ne le fasse).

Crédits d’image : Google

Il ne nous reste donc que Gemini Pro – et très probablement un Gemini Ultra peu convaincant, surtout si la fenêtre contextuelle du modèle reste à ~24 000 mots, comme indiqué dans le livre blanc technique. (La fenêtre contextuelle fait référence au texte que le modèle prend en compte avant de générer tout texte supplémentaire). Le GPT-4 dépasse largement cette fenêtre contextuelle (~100 000 mots), mais il est vrai que la fenêtre contextuelle n’est pas tout ; nous réserverons notre jugement jusqu’à ce que nous puissions mettre la main sur le modèle.

Se pourrait-il que le marketing de Google, qui a laissé entendre que Gemini serait quelque chose de vraiment remarquable plutôt qu’un léger déplacement de l’aiguille de l’IA générative, soit à blâmer pour le lancement raté d’aujourd’hui ? Peut-être. Ou peut-être que la construction de modèles d’IA générative de pointe est vraiment difficile, même si l’on réorganise l’ensemble de la division IA pour accélérer le processus.